Variance là gì? Công thức tính và vai trò trong thống kê dữ liệu

Trong phân tích dữ liệu, có một câu hỏi rất thực tế: dữ liệu của bạn “dao động” nhiều hay ít quanh giá trị trung bình? Câu trả lời thường bắt đầu từ xulysolieu.info với một khái niệm nền tảng: variance. Dù bạn đang học thống kê, làm báo cáo doanh nghiệp hay theo dõi hiệu quả đầu tư, variance giúp bạn nhìn thấy mức độ phân tán của dữ liệu một cách định lượng.

Variance là gì?

variance (phương sai) là một thước đo cho biết các giá trị trong tập dữ liệu khác nhau bao nhiêu so với giá trị trung bình. Nói đơn giản: variance càng lớn thì dữ liệu càng “tản” rộng; variance càng nhỏ thì dữ liệu càng “tụ” gần trung bình. Trong thống kê, variance được hiểu là trung bình của các độ lệch đã được bình phương so với trung bình.

Khi bạn làm phân tích dữ liệu, variance đóng vai trò như một “đồng hồ đo độ phân tán”. Nhờ variance, ta không chỉ nhìn dữ liệu bằng cảm giác (nhìn bảng số thấy “có vẻ” chênh), mà có thể đo được mức chênh lệch bằng con số rõ ràng, so sánh giữa nhóm này với nhóm khác, hoặc theo thời gian.

Variance khác gì so với độ lệch chuẩn?

variance và độ lệch chuẩn đều đo mức độ phân tán của dữ liệu, nhưng chúng khác nhau ở cách biểu diễn và độ “dễ đọc”. Độ lệch chuẩn (standard deviation) chính là căn bậc hai của variance. Điều này dẫn đến điểm khác biệt quan trọng:

- Độ lệch chuẩn có đơn vị giống dữ liệu gốc (ví dụ: điểm, mét, triệu đồng), nên trực quan và dễ giải thích.

- variance có đơn vị bình phương (ví dụ: mét²), nên khó hình dung hơn nếu chỉ nhìn con số.

Vậy vì sao variance vẫn rất quan trọng? Vì variance là “nguyên liệu” cốt lõi trong nhiều suy luận thống kê và mô hình hóa: từ ước lượng, kiểm định giả thuyết, hồi quy, đến nhiều kỹ thuật trong phân tích dữ liệu. Nói cách khác, độ lệch chuẩn dễ đọc hơn, nhưng variance thường xuất hiện trực tiếp trong công thức và thuật toán.

Variance cho bạn biết điều gì về dữ liệu?

Khi variance tăng, điều đó cho thấy các quan sát cách xa giá trị trung bình hơn, nghĩa là độ phân tán lớn hơn. Ngược lại, variance thấp cho thấy dữ liệu ổn định hơn, ít biến động hơn quanh trung bình.

Trong thực tế, variance rất hữu ích khi bạn cần:

- So sánh độ phân tán giữa hai nhóm (ví dụ: điểm lớp A có ổn định hơn lớp B không?).

- Đánh giá biến động theo thời gian (ví dụ: doanh thu tháng này dao động mạnh hơn tháng trước?).

- Phát hiện rủi ro (dữ liệu càng biến động, rủi ro càng cao trong nhiều bối cảnh).

Ứng dụng của variance trong các lĩnh vực

variance không chỉ xuất hiện trong sách thống kê, mà còn nằm ngay trong các công việc hằng ngày của nhiều ngành:

1) Thống kê và phân tích dữ liệu

Trong thống kê, variance là thước đo cơ bản của độ phân tán. Nhiều khái niệm quan trọng được xây dựng dựa trên variance như: phương sai mẫu, phương sai tổng thể, sai số, độ tin cậy, và các mô hình trong phân tích dữ liệu.

2) Tài chính và đầu tư

Trong đầu tư, variance thường được dùng để mô tả mức biến động lợi suất. Khi variance của lợi suất cao, lợi nhuận có thể dao động mạnh, đồng nghĩa rủi ro cao hơn. Các nhà phân tích dùng variance để so sánh mức biến động giữa tài sản, hoặc đánh giá đóng góp rủi ro của từng phần trong danh mục.

3) Kế toán quản trị và lập ngân sách

Trong quản trị, variance được hiểu là chênh lệch giữa thực tế và kế hoạch/khả năng kỳ vọng. Doanh nghiệp dùng variance để kiểm soát chi phí, theo dõi thu nhập, phát hiện điểm “vượt ngân sách” hoặc “thiếu hụt”, từ đó điều chỉnh vận hành. Nếu bạn cần chuẩn hóa báo cáo chênh lệch, có thể tham khảo thêm tại xulysolieu.info (Xử lý số liệu) hoặc liên hệ 0878968468 để được tư vấn theo tình huống dữ liệu.

Các nhóm variance thường gặp trong thực tế quản trị

Trong bối cảnh ngân sách và quản trị, variance thường được diễn giải theo dạng chênh lệch, giúp ra quyết định nhanh:

- Phương sai thu nhập: chênh lệch giữa thu nhập thực tế và thu nhập dự kiến. Nếu thực tế cao hơn dự kiến, đó là chênh lệch thuận lợi; ngược lại là bất lợi.

- Phương sai chi phí: chênh lệch giữa chi phí thực tế và chi phí ngân sách. Chi thấp hơn kế hoạch là thuận lợi; chi vượt là bất lợi.

- Phương sai lãi/lỗ: chênh lệch giữa kết quả lợi nhuận thực tế và kế hoạch (hoặc kỳ vọng), giúp đánh giá hiệu quả tổng quan.

Dù cách gọi khác nhau, điểm chung là bạn đang đo độ lệch giữa “thực tế” và “mục tiêu”. Trong khi đó, variance trong thống kê tập trung vào độ lệch giữa “giá trị quan sát” và “giá trị trung bình”. Hai góc nhìn khác nhau nhưng cùng tinh thần: đo chênh lệch bằng con số.

Công thức tính variance (phương sai)

Về mặt thống kê, variance được tính bằng cách:

- Tính giá trị trung bình của tập dữ liệu.

- Lấy từng giá trị trừ cho trung bình để ra độ lệch.

- Bình phương từng độ lệch (để loại bỏ dấu âm và nhấn mạnh độ lệch lớn).

- Cộng tất cả các độ lệch bình phương.

- Chia cho số lượng quan sát để lấy trung bình độ lệch bình phương.

Công thức mô tả tổng quát:

Var(X) = E(x − μ)2 / N

- x: giá trị trong tập dữ liệu

- μ: giá trị trung bình

- N: số lượng quan sát

Sau khi có variance, độ lệch chuẩn chỉ đơn giản là căn bậc hai của variance. Điều này giải thích vì sao variance hay được dùng trong suy luận thống kê, còn độ lệch chuẩn hay được dùng khi trình bày kết quả cho dễ hiểu.

Ví dụ tính variance dễ hiểu

Giả sử lợi nhuận của một cổ phiếu trong 3 năm lần lượt là 10%, 20% và 15%. Trung bình là 15%.

- Năm 1: 10% − 15% = −5% → (−5%)2 = 25

- Năm 2: 20% − 15% = 5% → (5%)2 = 25

- Năm 3: 15% − 15% = 0% → (0%)2 = 0

Trung bình các độ lệch bình phương:

(25 + 25 + 0) / 3 = 16,67

Như vậy variance của lợi nhuận xấp xỉ 16,67 (đơn vị bình phương theo cách bạn quy đổi). Thông điệp quan trọng ở đây là: variance giúp bạn lượng hóa mức biến động quanh trung bình, từ đó đánh giá độ phân tán của dữ liệu thay vì chỉ “nhìn cảm tính”.

Ưu điểm và hạn chế khi dùng variance

Ưu điểm

- variance cho bạn một con số rõ ràng về độ phân tán, rất hữu ích trong thống kê và phân tích dữ liệu.

- Do dùng bình phương, variance phản ánh mạnh hơn các độ lệch lớn, phù hợp khi bạn muốn “nhạy” với biến động.

- variance xử lý độ lệch dương/âm công bằng nhờ bình phương, tránh triệt tiêu lẫn nhau.

Hạn chế

- Do bình phương độ lệch, variance có thể bị ảnh hưởng mạnh bởi ngoại lệ (outlier). Một vài giá trị quá lớn/nhỏ có thể làm variance tăng vọt.

- Đơn vị bình phương khiến variance khó diễn giải trực quan, vì vậy khi trình bày báo cáo, người ta hay kèm độ lệch chuẩn.

Khi nào nên ưu tiên variance trong phân tích dữ liệu?

Bạn nên dùng variance khi làm việc với các mô hình và suy luận thống kê, hoặc khi bạn cần một thước đo gốc để xây dựng các phân tích sâu hơn. Trong thực hành phân tích dữ liệu, variance thường xuất hiện trong:

- So sánh độ phân tán giữa các nhóm dữ liệu.

- Đánh giá biến động và rủi ro trong chuỗi thời gian.

- Chuẩn bị dữ liệu cho mô hình hóa (nhiều thuật toán dùng variance trực tiếp hoặc gián tiếp).

Nếu bạn đang học thống kê hoặc cần áp dụng variance vào báo cáo thực tế (doanh nghiệp, nghiên cứu, đầu tư), hãy bắt đầu bằng việc hiểu đúng bản chất “độ phân tán” và cách variance được tính. Khi cần hệ thống hóa kiến thức và bài tập theo tình huống, bạn có thể xem thêm tài liệu tại xulysolieu.info (Xử lý số liệu) hoặc liên hệ 0878968468.

Kết luận

variance là nền tảng để đo độ phân tán trong thống kê và phân tích dữ liệu. Dù đôi khi khó hình dung vì đơn vị bình phương, variance lại rất mạnh trong việc hỗ trợ suy luận thống kê, đo biến động, và đánh giá rủi ro. Khi bạn nắm chắc variance, bạn sẽ đọc dữ liệu “có chiều sâu” hơn: không chỉ biết trung bình là bao nhiêu, mà còn biết dữ liệu ổn định hay dao động mạnh quanh trung bình.

Cấu trúc tuyến tính là gì? Vai trò trong mô hình toán và phân tích dữ liệu

Trong hơn một thế kỷ qua, phân tích thống kê đã trở thành nền tảng không thể thiếu của khoa học xã hội, kinh tế và quản trị. Cùng với sự phát triển mạnh mẽ của công nghệ máy tính, các phương pháp phân tích dữ liệu ngày càng trở nên đa dạng, linh hoạt và dễ tiếp cận hơn. Trong bối cảnh đó, câu hỏi cấu trúc tuyến tính là gì ngày càng được quan tâm, đặc biệt khi các nhà nghiên cứu cần mô hình hóa những mối quan hệ phức tạp giữa nhiều biến số.

Ban đầu, các nghiên cứu chủ yếu dựa trên phân tích đơn biến và song biến để mô tả dữ liệu. Tuy nhiên, các vấn đề nghiên cứu hiện đại đòi hỏi phải xem xét đồng thời nhiều mối quan hệ, nhiều biến quan sát và cả các khái niệm trừu tượng khó đo lường. Đây chính là lý do khiến cấu trúc tuyến tính và các mô hình tuyến tính đa biến đóng vai trò trung tâm trong phân tích dữ liệu ngày nay.

Cấu trúc tuyến tính là gì trong toán học và thống kê?

Để hiểu rõ cấu trúc tuyến tính là gì, trước hết cần nhìn từ góc độ toán học. Trong đại số tuyến tính, cấu trúc tuyến tính mô tả mối quan hệ giữa các đại lượng thông qua các tổ hợp tuyến tính, vectơ, ma trận và không gian vectơ. Các quan hệ này tuân theo tính tuyến tính, tức là sự thay đổi của biến đầu vào dẫn đến sự thay đổi tỷ lệ tương ứng ở biến đầu ra.

Khi chuyển sang lĩnh vực thống kê và phân tích dữ liệu, cấu trúc tuyến tính được sử dụng để mô hình hóa mối quan hệ giữa các biến thông qua các phương trình hồi quy. Một mô hình tuyến tính có thể biểu diễn mối liên hệ giữa biến phụ thuộc và một hoặc nhiều biến độc lập, từ đó giúp nhà nghiên cứu giải thích, dự báo và kiểm định giả thuyết.

Như vậy, cấu trúc tuyến tính là gì có thể được hiểu một cách ngắn gọn: đó là cách tổ chức và biểu diễn mối quan hệ giữa các biến dựa trên nguyên lý tuyến tính, làm nền tảng cho nhiều phương pháp phân tích định lượng.

Vai trò của cấu trúc tuyến tính trong phân tích dữ liệu

Trong phân tích dữ liệu hiện đại, cấu trúc tuyến tính giữ vai trò cốt lõi vì nó cho phép xử lý đồng thời nhiều mối quan hệ phức tạp trong một khung mô hình thống nhất. Thông qua các mô hình tuyến tính, nhà nghiên cứu có thể:

- Phân tích tác động của nhiều biến độc lập lên một hoặc nhiều biến phụ thuộc;

- Giải quyết vấn đề đa cộng tuyến thường gặp trong hồi quy;

- Kết hợp dữ liệu quan sát với các giả định nhân quả;

- Đánh giá mức độ phù hợp của mô hình với dữ liệu thực tế.

Chính vì vậy, việc hiểu rõ cấu trúc tuyến tính là gì giúp người làm phân tích dữ liệu lựa chọn được phương pháp phù hợp, tránh lạm dụng các kỹ thuật phức tạp khi mô hình tuyến tính đã đủ khả năng giải thích vấn đề.

Mô hình cấu trúc tuyến tính SEM và ý nghĩa thực tiễn

Một trong những ứng dụng quan trọng nhất của cấu trúc tuyến tính trong thống kê là mô hình cấu trúc tuyến tính SEM (Structural Equation Modeling). Đây được xem là kỹ thuật phân tích thế hệ thứ hai, cho phép kết hợp hồi quy, phân tích đường dẫn và phân tích nhân tố trong cùng một mô hình.

SEM mở rộng khái niệm mô hình tuyến tính truyền thống bằng cách cho phép đưa các biến tiềm ẩn vào phân tích. Các biến này không đo lường trực tiếp mà được suy ra từ nhiều biến quan sát, rất phù hợp với nghiên cứu hành vi, quản trị, marketing và khoa học xã hội.

Từ góc độ ứng dụng, hiểu cấu trúc tuyến tính là gì trong SEM giúp nhà nghiên cứu:

- Phân tích đồng thời nhiều phương trình hồi quy;

- Mô hình hóa mối quan hệ đa chiều giữa các khái niệm;

- Đánh giá trực quan các mối quan hệ nguyên nhân – kết quả;

- Ưu tiên nguồn lực dựa trên kết quả phân tích dữ liệu.

CB-SEM và PLS-SEM: Hai hướng tiếp cận phổ biến

Hiện nay, hai phương pháp được sử dụng phổ biến nhất trong SEM là CB-SEM và PLS-SEM. Mỗi cách tiếp cận phản ánh một cách hiểu khác nhau về cấu trúc tuyến tính là gì trong nghiên cứu thực nghiệm.

CB-SEM (SEM dựa trên hiệp phương sai) tập trung vào việc kiểm định lý thuyết. Phương pháp này đánh giá mức độ mà mô hình lý thuyết đề xuất có thể tái tạo ma trận hiệp phương sai của dữ liệu mẫu. Do đó, CB-SEM thường được sử dụng trong các nghiên cứu xác nhận, nơi lý thuyết đã được xây dựng rõ ràng.

Ngược lại, PLS-SEM (SEM dựa trên bình phương nhỏ nhất từng phần) nhấn mạnh vào việc giải thích phương sai của biến phụ thuộc. Phương pháp này phù hợp với nghiên cứu khám phá, mẫu nhỏ, hoặc khi mục tiêu chính là dự báo hơn là kiểm định lý thuyết.

Việc lựa chọn CB-SEM hay PLS-SEM phụ thuộc vào mục tiêu nghiên cứu, đặc điểm dữ liệu và cách tiếp cận lý thuyết. Dù theo hướng nào, nền tảng vẫn là hiểu đúng cấu trúc tuyến tính là gì và cách nó vận hành trong mô hình tuyến tính.

Mối liên hệ giữa đại số tuyến tính, hồi quy và cấu trúc tuyến tính

Không thể bàn về cấu trúc tuyến tính là gì mà không nhắc đến đại số tuyến tính. Các khái niệm như ma trận, vectơ, trị riêng và không gian con chính là công cụ toán học giúp biểu diễn và giải quyết các mô hình tuyến tính trong phân tích dữ liệu.

Trong hồi quy tuyến tính, toàn bộ mô hình có thể được viết dưới dạng ma trận, cho phép xử lý dữ liệu lớn và phức tạp một cách hiệu quả. Điều này lý giải vì sao đại số tuyến tính là nền tảng bắt buộc đối với những ai muốn đi sâu vào phân tích dữ liệu và mô hình hóa.

Từ hồi quy đơn giản đến SEM phức tạp, cấu trúc tuyến tính luôn đóng vai trò “xương sống”, liên kết các biến và giả thuyết trong một hệ thống logic nhất quán.

Kết luận

Tóm lại, việc hiểu rõ cấu trúc tuyến tính là gì không chỉ mang ý nghĩa lý thuyết mà còn có giá trị thực tiễn rất lớn trong phân tích dữ liệu. Từ mô hình tuyến tính cơ bản, hồi quy đa biến đến mô hình cấu trúc tuyến tính SEM, tất cả đều dựa trên cùng một nguyên lý tuyến tính cốt lõi.

Đối với người học và người làm nghiên cứu, nắm vững cấu trúc tuyến tính là gì sẽ giúp tiếp cận các phương pháp phân tích hiện đại một cách bài bản, tránh sai lầm trong mô hình hóa và nâng cao chất lượng kết quả nghiên cứu.

Nếu bạn cần tư vấn, đào tạo hoặc triển khai các mô hình phân tích dữ liệu và mô hình cấu trúc tuyến tính trong thực tế, hãy liên hệ với xulysolieu.info – Xử lý số liệu hoặc truy cập xulysolieu.info. Hotline hỗ trợ: 0878968468.

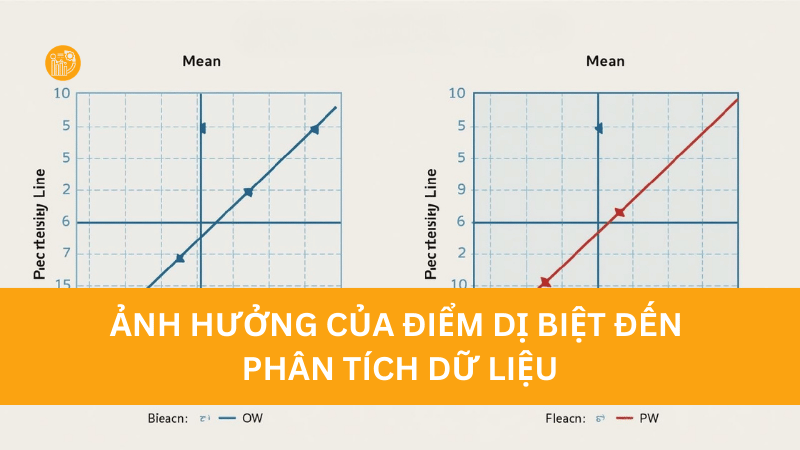

Điểm dị biệt là gì? Cách nhận diện và xử lý trong phân tích dữ liệu

Trong quá trình làm việc với dữ liệu, đặc biệt là khi phân tích định lượng, một khái niệm thường xuyên được nhắc đến nhưng cũng dễ gây hiểu nhầm chính là điểm dị biệt. Vậy dị biệt là gì, vì sao cần quan tâm đến chúng và xử lý như thế nào để không làm sai lệch kết quả nghiên cứu? Bài viết này sẽ giúp bạn hiểu rõ bản chất của điểm dị biệt, cách phân loại, cách nhận diện và nguyên tắc xử lý đúng đắn trong phân tích dữ liệu theo hướng dễ hiểu, mang tính giáo dục và thực tiễn.

Dị biệt là gì?

Dị biệt là gì? Dị biệt (hay còn gọi là điểm dị biệt, outlier) là những quan sát có giá trị khác biệt rõ rệt so với phần lớn dữ liệu còn lại. Các điểm này không tuân theo xu hướng chung của tập dữ liệu và thường nằm rất xa trung tâm phân phối.

Trong thống kê mô tả và phân tích dữ liệu, điểm dị biệt có thể xuất hiện do nhiều nguyên nhân như lỗi nhập liệu, trả lời không hợp lệ, sự kiện bất thường hoặc đơn giản là một quan sát hiếm nhưng có thật trong thực tế.

Khi một tập dữ liệu xuất hiện quá nhiều điểm dị biệt, các ước lượng thống kê như trung bình, độ lệch chuẩn, hệ số hồi quy có thể bị bóp méo, từ đó làm giảm độ chính xác và độ tin cậy của kết quả phân tích.

Vì sao cần quan tâm đến điểm dị biệt?

Hiểu dị biệt là gì giúp bạn nhận thức được vai trò của bước làm sạch dữ liệu trong nghiên cứu. Điểm dị biệt có thể:

- Làm sai lệch các chỉ số trung tâm như mean.

- Làm tăng phương sai và độ lệch chuẩn.

- Ảnh hưởng đến kết quả kiểm định giả thuyết.

- Làm mô hình hồi quy kém ổn định hoặc mất ý nghĩa thống kê.

Do đó, việc nhận diện và đánh giá đúng điểm dị biệt là bước không thể thiếu trong phân tích dữ liệu nghiêm túc.

Cơ chế nhận diện điểm dị biệt

Về bản chất, việc nhận diện điểm dị biệt thường dựa trên tính chuẩn hóa của dữ liệu. Những giá trị khiến dữ liệu khó đạt được phân phối chuẩn hoặc làm phá vỡ cấu trúc phân phối chung sẽ được xem là điểm dị biệt cần xem xét.

Tuy nhiên, không phải mọi điểm dị biệt đều phải loại bỏ. Điều quan trọng là hiểu dị biệt là gì và phân biệt được đâu là dị biệt “xấu” (do lỗi) và đâu là dị biệt “thật” (phản ánh thực tế).

Phân loại điểm dị biệt theo tính chất

Xét theo bản chất, điểm dị biệt có thể được chia thành hai loại chính:

Điểm dị biệt loại 1: dễ nhận diện

Đây là các điểm dị biệt có thể phát hiện thông qua thống kê tần số, bảng kết hợp hoặc kiểm tra logic dữ liệu. Các điểm này thường vi phạm quy định giá trị hoặc logic thông tin.

Ví dụ: biến giới tính chỉ được mã hóa là 1 (nam) và 2 (nữ) nhưng trong dữ liệu lại xuất hiện giá trị 3 hoặc 9. Hoặc một người có độ tuổi 18 nhưng thâm niên làm việc được ghi nhận là 20 năm. Những trường hợp này rõ ràng không hợp lý và được xem là điểm dị biệt cần xử lý.

Điểm dị biệt loại 2: khó nhận diện

Khác với loại 1, các điểm dị biệt này vẫn hợp lệ về mặt quy định giá trị và logic thông tin, nhưng lại lệch mạnh so với xu hướng phân phối chung. Đây là dạng điểm dị biệt nguy hiểm hơn vì chúng khó phát hiện và có thể ảnh hưởng đáng kể đến kết quả thống kê.

Ví dụ: một nhân viên có mức thu nhập cao gấp nhiều lần so với phần lớn mẫu, hoặc một khách hàng có mức độ hài lòng cực thấp trong khi đa số đều đánh giá cao.

Phân loại điểm dị biệt theo số lượng biến

Nếu xét theo cách phân tích, điểm dị biệt còn được chia thành dị biệt đơn lẻ và dị biệt kết hợp.

Univariate outliers (dị biệt đơn lẻ)

Univariate outliers là những điểm dị biệt xuất hiện khi xét từng biến riêng biệt. Mỗi biến sẽ được kiểm tra độc lập để xác định các giá trị bất thường.

Ví dụ: khi phân tích riêng biến tuổi, bạn phát hiện một giá trị 120 trong khi phần lớn mẫu nằm trong khoảng 18–60. Đây là dị biệt đơn lẻ của biến tuổi, không cần xét đến các biến khác.

Multivariate outliers (dị biệt kết hợp)

Multivariate outliers xuất hiện khi xét đồng thời từ hai biến trở lên. Một điểm dữ liệu có thể không dị biệt ở từng biến riêng lẻ nhưng lại trở thành dị biệt khi xét mối quan hệ giữa các biến.

Ví dụ: một người có thâm niên làm việc và mức độ hài lòng đều nằm trong phạm vi hợp lý, nhưng khi kết hợp hai biến này lại cho ra một mẫu quá khác biệt so với phần còn lại. Điểm này có thể không trùng với dị biệt đơn lẻ của từng biến.

Ảnh hưởng của điểm dị biệt đến phân tích dữ liệu

Hiểu rõ dị biệt là gì giúp bạn nhận thức được rằng điểm dị biệt không chỉ ảnh hưởng đến thống kê mô tả mà còn tác động mạnh đến các phân tích suy luận.

Trong hồi quy, điểm dị biệt có thể làm thay đổi độ dốc đường hồi quy. Trong kiểm định, chúng có thể khiến kết quả từ có ý nghĩa trở thành không có ý nghĩa hoặc ngược lại. Trong mô hình phức tạp, việc xử lý sai điểm dị biệt còn có thể làm giảm độ phù hợp mô hình.

Nguyên tắc xử lý điểm dị biệt

Việc xử lý điểm dị biệt cần được thực hiện một cách thận trọng. Không nên xem việc loại bỏ outlier là cách “làm đẹp” số liệu.

Chỉ nên cân nhắc loại bỏ điểm dị biệt khi:

- Giá trị nằm ngoài phạm vi thang đo.

- Dữ liệu vi phạm logic thông tin rõ ràng.

- Điểm quá khác biệt và không đại diện cho tổng thể nghiên cứu.

Nếu điểm dị biệt phản ánh câu trả lời thực tế của đối tượng nghiên cứu, việc loại bỏ có thể làm mất đi tính chân thực của dữ liệu.

Rủi ro khi lạm dụng loại bỏ điểm dị biệt

Nhiều người mới học phân tích dữ liệu thường mắc sai lầm khi hiểu dị biệt là gì nhưng lại xử lý quá tay. Việc loại bỏ điểm dị biệt thiếu cân nhắc có thể:

- Làm giảm cỡ mẫu.

- Làm sai lệch đặc điểm tổng thể.

- Khiến mô hình phân tích kém phản ánh thực tế.

Thậm chí, trong một số trường hợp, việc loại bỏ outlier còn làm kết quả phân tích xấu đi, ví dụ mô hình hồi quy giảm độ phù hợp hoặc các biến quan trọng trở nên không có ý nghĩa.

Tiếp cận đúng trong làm sạch dữ liệu

Làm sạch dữ liệu không chỉ là loại bỏ điểm dị biệt mà là quá trình thử – sai, đánh giá tác động của từng quyết định xử lý lên kết quả phân tích.

Mục tiêu cuối cùng không phải là các chỉ số “đẹp”, mà là kết quả phản ánh đúng bản chất dữ liệu và câu hỏi nghiên cứu ban đầu.

Hỗ trợ xử lý điểm dị biệt và phân tích dữ liệu

Nếu bạn gặp khó khăn trong việc nhận diện, đánh giá và xử lý điểm dị biệt trong SPSS hoặc các phần mềm phân tích dữ liệu khác, bạn có thể tham khảo dịch vụ tại xulysolieu.info – Xử lý số liệu. Đội ngũ hỗ trợ tập trung vào việc làm sạch dữ liệu, kiểm tra giả định thống kê và hướng dẫn xử lý outlier một cách hợp lý.

Kết luận

Dị biệt là gì? Điểm dị biệt là những quan sát khác biệt rõ rệt so với xu hướng chung của dữ liệu và có thể ảnh hưởng mạnh đến kết quả phân tích. Việc nhận diện và xử lý điểm dị biệt là bước quan trọng trong làm sạch dữ liệu, nhưng cần được thực hiện cẩn trọng và có lập luận khoa học. Khi hiểu đúng bản chất của điểm dị biệt, bạn sẽ biết cách cân bằng giữa độ chính xác thống kê và tính thực tế của nghiên cứu.

Giá trị trung bình là gì? Phân biệt trung bình số học và trung bình hình học

Nếu bạn từng xem một bảng điểm, bảng doanh thu, hay báo cáo hiệu suất đầu tư, chắc chắn bạn sẽ gặp “giá trị trung bình”. Đây là chỉ số quen thuộc trong thống kê mô tả nhưng lại dễ bị dùng sai, nhất là khi dữ liệu có biến động mạnh. Bài viết này của xulysolieu.info (Xử lý số liệu) sẽ giải thích rõ giá trị trung bình là gì, cách tính, khi nào nên dùng trung bình số học, khi nào nên dùng trung bình hình học, và vì sao trong phân tích dữ liệu, chọn sai loại trung bình có thể dẫn đến kết luận lệch.

1) Giá trị trung bình là gì?

Giá trị trung bình là gì? Hiểu đơn giản, giá trị trung bình là gì chính là “mức bình quân” của một tập hợp gồm hai hoặc nhiều số. Trong tiếng Anh, giá trị trung bình thường được gọi là mean. Trong thống kê mô tả, giá trị trung bình là gì được xem như một đại diện tổng quát cho xu hướng trung tâm của dữ liệu.

Về mặt trực giác, khi bạn cộng tất cả các giá trị lại rồi chia đều cho số lượng phần tử, bạn sẽ nhận được một con số biểu diễn “mỗi phần tử trung bình tương đương bao nhiêu”. Đây là cách hiểu phổ biến nhất khi hỏi giá trị trung bình là gì.

Tuy nhiên, trong thực hành phân tích dữ liệu, giá trị trung bình là gì không chỉ có một cách tính. Hai dạng thường dùng nhất là trung bình số học và trung bình hình học. Cả hai đều là mean nhưng phù hợp cho những bối cảnh khác nhau.

2) Vai trò của giá trị trung bình trong thống kê mô tả

Giá trị trung bình là gì trong thống kê mô tả? Nó là một chỉ số giúp bạn tóm tắt dữ liệu nhanh chóng và dễ so sánh giữa các nhóm. Ví dụ:

- Trong học tập: trung bình điểm để đánh giá kết quả học kỳ.

- Trong kinh doanh: trung bình doanh thu theo tháng để nhìn xu hướng hiệu suất.

- Trong tài chính: trung bình lợi nhuận trong một giai đoạn để ước tính hiệu quả đầu tư.

Nhưng nếu dữ liệu biến động mạnh (đặc biệt là lợi nhuận theo ngày, theo tuần), bạn cần cân nhắc loại mean phù hợp. Đây là lý do vì sao câu hỏi giá trị trung bình là gì luôn nên đi kèm câu hỏi “trung bình nào?”.

3) Trung bình số học: công thức và cách hiểu

Khi người ta hỏi giá trị trung bình là gì, phần lớn đang nói đến trung bình số học. Trung bình số học là cách tính đơn giản nhất: lấy tổng các giá trị chia cho số lượng giá trị.

Công thức trung bình số học:

Trung bình số học = (x1 + x2 + … + xn) / n

Trong nhiều bài toán thống kê mô tả, trung bình số học là lựa chọn hợp lý vì dễ tính và dễ giải thích. Tuy nhiên, trung bình số học chỉ phản ánh tốt khi dữ liệu tương đối ổn định, ít biến động cực đoan.

Vì vậy, nếu bạn đang phân tích dữ liệu kiểu “điểm số”, “nhiệt độ”, “thời gian xử lý” (các đại lượng không gộp theo tỉ lệ tăng trưởng), trung bình số học thường phù hợp khi giải thích giá trị trung bình là gì.

4) Trung bình hình học: khi nào cần dùng?

Giá trị trung bình là gì trong bối cảnh tăng trưởng, lãi suất, lợi nhuận đầu tư? Lúc này, trung bình hình học thường phản ánh chính xác hơn. Trung bình hình học phù hợp với dữ liệu có tính “gộp” theo thời gian, tức giá trị sau phụ thuộc giá trị trước thông qua nhân (ví dụ tăng 2% rồi giảm 1% không thể cộng đơn giản).

Công thức trung bình hình học:

Trung bình hình học = (x1 × x2 × … × xn)1/n

Nếu x là các hệ số tăng trưởng, bạn thường chuyển lợi nhuận phần trăm về dạng “1 + r” để đảm bảo số dương, sau đó lấy căn bậc n và trừ 1 để quay lại lợi nhuận trung bình.

Đây là điểm rất quan trọng khi học giá trị trung bình là gì trong tài chính: lợi nhuận có biến động thì trung bình hình học thường “thật” hơn trung bình số học.

5) Ví dụ trực quan: vì sao trung bình hình học thường chính xác hơn với lợi nhuận?

Giả sử bạn theo dõi lợi nhuận cổ phiếu trong nhiều ngày. Nếu chỉ lấy trung bình số học của lợi nhuận, bạn đang giả định lợi nhuận mỗi ngày “cộng dồn tuyến tính”. Trong khi thực tế, giá cổ phiếu biến động theo cơ chế gộp (compounding): giá ngày sau = giá ngày trước × (1 + r).

Khi đó, giá trị trung bình là gì để phản ánh đúng hiệu suất thực tế? Trung bình hình học thường cho kết quả bám sát hơn, vì nó mô phỏng đúng cơ chế nhân theo chuỗi thời gian.

Một đặc điểm toán học quan trọng: trung bình hình học luôn nhỏ hơn hoặc bằng trung bình số học (khi các giá trị không âm). Vì vậy, trong dữ liệu có biến động, trung bình số học thường “đánh bóng” kết quả, còn trung bình hình học thận trọng hơn.

Nếu bạn đang học phân tích dữ liệu đầu tư, đây là lý do cốt lõi giải thích giá trị trung bình là gì và vì sao không nên mặc định dùng trung bình số học cho lợi nhuận.

6) Phân biệt trung bình số học và trung bình hình học (bảng so sánh nhanh)

| Tiêu chí | Trung bình số học | Trung bình hình học |

|---|---|---|

| Bản chất | Cộng rồi chia đều | Nhân rồi lấy căn bậc n |

| Phù hợp | Dữ liệu ổn định, đo lường tuyến tính | Dữ liệu gộp theo thời gian: tăng trưởng, lợi nhuận |

| Nhạy với biến động | Dễ bị “đẩy cao” khi biến động lớn | Phản ánh thực tế gộp tốt hơn |

| Quan hệ toán học | ≥ trung bình hình học | ≤ trung bình số học |

Bảng trên giúp bạn thấy rõ giá trị trung bình là gì theo từng ngữ cảnh và tránh nhầm lẫn giữa hai loại mean.

7) Khi nào dùng loại mean nào trong phân tích dữ liệu?

Để trả lời triệt để giá trị trung bình là gì trong thực hành, bạn có thể dùng quy tắc đơn giản sau:

- Dùng trung bình số học khi dữ liệu là các mức đo “độc lập theo phép cộng” như điểm số, nhiệt độ, thời gian, chi phí từng hạng mục.

- Dùng trung bình hình học khi dữ liệu là chuỗi tăng trưởng, lợi nhuận, lãi suất, hoặc bất kỳ đại lượng nào “gộp” theo phép nhân.

Trong thống kê mô tả, nhiều người chỉ dùng trung bình số học vì tiện. Nhưng khi dữ liệu có biến động, câu hỏi giá trị trung bình là gì sẽ không còn đơn giản, và chọn đúng loại mean mới là điều quyết định.

8) Lưu ý quan trọng khi diễn giải giá trị trung bình

Dù bạn dùng trung bình số học hay trung bình hình học, giá trị trung bình là gì vẫn chỉ là một chỉ số tóm tắt. Để phân tích chắc chắn hơn, bạn nên kết hợp thêm các thước đo khác như độ lệch chuẩn, trung vị, tứ phân vị hoặc biểu đồ phân phối. Điều này giúp bạn tránh trường hợp mean “đẹp” nhưng dữ liệu thực tế lại phân tán mạnh hoặc có ngoại lệ lớn.

Nói cách khác, giá trị trung bình là gì giúp bạn nhìn nhanh, nhưng muốn hiểu sâu thì cần đặt mean trong bối cảnh của toàn bộ dữ liệu.

9) Kết luận

Giá trị trung bình là gì? Đó là chỉ số mean biểu diễn mức bình quân của một tập dữ liệu, thường dùng trong thống kê mô tả để tóm tắt và so sánh. Trung bình số học phù hợp với dữ liệu tuyến tính và tương đối ổn định, còn trung bình hình học phù hợp với dữ liệu tăng trưởng, lợi nhuận có cơ chế gộp và biến động. Khi nắm chắc giá trị trung bình là gì và phân biệt đúng hai loại trung bình, bạn sẽ đọc báo cáo dữ liệu chính xác hơn và tránh kết luận sai do chọn nhầm thước đo.

Nếu bạn cần hỗ trợ giải thích mean trong báo cáo, tính trung bình số học/trung bình hình học, hoặc hệ thống kiến thức thống kê mô tả theo hướng dễ hiểu, hãy liên hệ xulysolieu.info (Xử lý số liệu) qua số 0878968468.

Hồi quy tuyến tính là gì? Khái niệm, mô hình và ứng dụng trong phân tích dữ liệu

Trong lĩnh vực phân tích dữ liệu, có một câu hỏi xuất hiện rất thường xuyên: hồi quy tuyến tính là gì và vì sao phương pháp này lại được dùng phổ biến đến vậy? Thực tế, hồi quy tuyến tính (linear regression) là một kỹ thuật nền tảng trong thống kê suy luận và mô hình dự báo. Nhờ tính trực quan, dễ giải thích và triển khai nhanh trên nhiều phần mềm, hồi quy tuyến tính trở thành “bước nhập môn” quan trọng cho người học dữ liệu, đồng thời cũng là công cụ thực chiến trong kinh doanh, nghiên cứu khoa học và học máy.

Hồi quy tuyến tính là gì?

Hồi quy tuyến tính là gì? Đây là phương pháp mô hình hóa mối quan hệ giữa một biến phụ thuộc (y) và một hoặc nhiều biến độc lập (x). Mục tiêu của hồi quy tuyến tính là dùng biến độc lập để giải thích hoặc dự đoán giá trị của biến phụ thuộc thông qua một phương trình dạng đường thẳng.

Ví dụ đơn giản: nếu bạn có dữ liệu thu nhập và chi tiêu trong năm trước, hồi quy tuyến tính có thể giúp tìm ra quy luật “chi tiêu thường bằng một tỷ lệ nào đó của thu nhập”. Từ đó, khi biết thu nhập dự kiến trong tương lai, bạn có thể ước lượng chi tiêu tương ứng. Đây chính là cách hồi quy tuyến tính là gì được ứng dụng như một mô hình dự báo trong thực tế.

Tại sao hồi quy tuyến tính lại quan trọng trong phân tích dữ liệu?

Khi nói đến hồi quy tuyến tính là gì, điều quan trọng không chỉ là định nghĩa mà còn nằm ở giá trị ứng dụng. Hồi quy tuyến tính quan trọng vì:

- Cung cấp công thức toán học rõ ràng, dễ giải thích cho người không chuyên.

- Giúp chuyển dữ liệu thô thành thông tin có ích phục vụ ra quyết định.

- Được sử dụng rộng rãi trong thống kê suy luận để kiểm định mối quan hệ giữa các biến.

- Là nền tảng cho nhiều phương pháp nâng cao trong khoa học dữ liệu và học máy.

Vì vậy, hiểu hồi quy tuyến tính là gì sẽ giúp bạn xây nền chắc trước khi học các kỹ thuật phức tạp hơn như hồi quy logistic, mô hình hỗn hợp hay các thuật toán dự báo nâng cao.

Hồi quy tuyến tính hoạt động như thế nào?

Để hiểu sâu hồi quy tuyến tính là gì, bạn cần hình dung cách phương pháp này “fit” một đường thẳng vào dữ liệu. Về trực quan, hồi quy tuyến tính cố gắng vẽ một đường thẳng sao cho đường đó “gần” các điểm dữ liệu nhất có thể.

Trong trường hợp đơn giản nhất với một biến độc lập, mô hình có dạng:

y = a + b*x

Trong đó:

- a là hằng số (intercept), thể hiện giá trị y khi x bằng 0.

- b là hệ số góc (slope), thể hiện mức thay đổi trung bình của y khi x tăng 1 đơn vị.

Chẳng hạn, nếu dữ liệu cho thấy y tăng đều khi x tăng, linear regression sẽ tìm b sao cho phù hợp nhất với xu hướng đó.

Phần dư và độ chính xác của mô hình

Một khái niệm cốt lõi khi học hồi quy tuyến tính là gì chính là phần dư. Phần dư là chênh lệch giữa giá trị quan sát thực tế và giá trị dự đoán từ mô hình. Mô hình càng tốt thì phần dư càng nhỏ và không tạo thành mô hình bất thường theo thời gian hoặc theo mức giá trị của x.

Trong phân tích dữ liệu, phần dư được dùng để kiểm tra xem mô hình dự báo có đang phù hợp hay không, đồng thời hỗ trợ đánh giá các giả định thống kê của hồi quy tuyến tính.

Bốn giả định thường gặp của hồi quy tuyến tính

Trong thống kê suy luận, hồi quy tuyến tính chỉ cho kết luận đáng tin cậy khi dữ liệu tương đối đáp ứng các giả định. Khi học hồi quy tuyến tính là gì, bạn nên nhớ 4 giả định hay gặp sau:

Mối quan hệ tuyến tính

Mối quan hệ giữa biến độc lập và biến phụ thuộc cần có dạng gần tuyến tính. Nếu quan hệ thực tế cong hoặc phi tuyến, bạn có thể cân nhắc biến đổi dữ liệu (log, căn bậc hai) để đưa về dạng gần tuyến tính hơn.

Phần dư độc lập

Phần dư không nên phụ thuộc lẫn nhau. Trường hợp dữ liệu theo chuỗi thời gian, người ta thường dùng kiểm định Durbin-Watson để xem có tự tương quan hay không.

Phân phối chuẩn của phần dư

Phần dư nên có phân phối gần chuẩn để các kiểm định thống kê suy luận hoạt động tốt. Một cách kiểm tra trực quan là dùng biểu đồ Q-Q. Nếu phần dư lệch nhiều, có thể do ngoại lai hoặc do mô hình chưa phù hợp.

Phương sai không đổi

Giả định phương sai không đổi (homoscedasticity) nghĩa là mức độ dao động của phần dư quanh đường hồi quy tương đối ổn định. Nếu phần dư “xòe” ra khi x tăng, mô hình có thể gặp vấn đề phương sai thay đổi, làm giảm độ tin cậy của kết luận.

Các loại hồi quy tuyến tính phổ biến

Khi đã hiểu hồi quy tuyến tính là gì, bạn sẽ thấy phương pháp này có nhiều biến thể phù hợp với từng bài toán phân tích dữ liệu.

Hồi quy tuyến tính đơn

Hồi quy tuyến tính đơn dùng một biến độc lập để dự đoán một biến phụ thuộc. Đây là dạng dễ hiểu nhất của linear regression, thường dùng để mô hình dự báo nhanh và phân tích mối quan hệ cơ bản.

Hồi quy tuyến tính bội

Hồi quy tuyến tính bội mở rộng mô hình khi có nhiều biến độc lập. Khi đó, mô hình dự báo có dạng tổng hợp của nhiều yếu tố, giúp giải thích dữ liệu thực tế tốt hơn vì hiếm khi một kết quả chỉ phụ thuộc vào một nguyên nhân.

Hồi quy logistic

Mặc dù tên gọi tương tự, hồi quy logistic thường được dùng để dự đoán xác suất xảy ra của một sự kiện (kết quả dạng 0/1). Hồi quy logistic không phải tuyến tính theo nghĩa đường thẳng, nhưng được xem là mở rộng tư duy từ hồi quy tuyến tính sang bài toán phân loại.

Ứng dụng của hồi quy tuyến tính trong thực tế

Hiểu hồi quy tuyến tính là gì sẽ giúp bạn nhận ra nó xuất hiện khắp nơi:

- Kinh tế: dự đoán giá nhà dựa trên diện tích, số phòng, vị trí.

- Giáo dục: phân tích điểm số theo thời gian học, mức độ tham gia, nền tảng kiến thức.

- Môi trường: dự báo mức ô nhiễm dựa trên mật độ giao thông, thời tiết, hoạt động công nghiệp.

- Doanh nghiệp: dự đoán doanh số theo ngân sách marketing, số lượt tiếp cận, giá bán.

Những ứng dụng này cho thấy hồi quy tuyến tính vừa là công cụ phân tích dữ liệu, vừa là nền tảng xây dựng mô hình dự báo trong nhiều lĩnh vực.

Hỗ trợ phân tích dữ liệu và xây dựng mô hình

Nếu bạn đang cần hỗ trợ áp dụng hồi quy tuyến tính, linear regression hoặc xây dựng mô hình dự báo cho đề tài nghiên cứu, bạn có thể tham khảo dịch vụ tại xulysolieu.info – Xử lý số liệu. Đội ngũ hỗ trợ theo hướng giáo dục, giúp bạn hiểu bản chất thống kê suy luận và triển khai phân tích dữ liệu đúng quy trình.

Kết luận

Hồi quy tuyến tính là gì? Đây là phương pháp mô hình hóa mối quan hệ giữa biến phụ thuộc và biến độc lập bằng một phương trình tuyến tính, được sử dụng rộng rãi trong phân tích dữ liệu, thống kê suy luận và mô hình dự báo. Khi nắm vững bản chất, giả định và các dạng linear regression, bạn sẽ có nền tảng vững để triển khai phân tích dữ liệu và tiến xa hơn trong các kỹ thuật dự báo hiện đại.

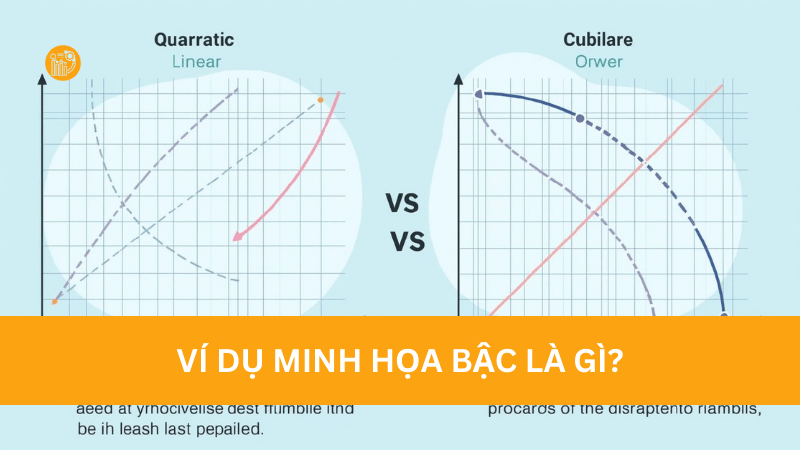

Bậc của đa thức là gì? Cách xác định nhanh và ứng dụng

Khi học đại số, bạn sẽ gặp rất nhiều biểu thức chứa biến như x, y, z… và đôi lúc chỉ cần nhìn “số mũ lớn nhất” là bạn đã có thể dự đoán được dạng đồ thị, số nghiệm tối đa hay mức độ phức tạp của bài toán. Vì thế, hiểu bậc là gì là một bước nền tảng để bạn làm tốt các chủ đề như phương trình, hàm số, phân tích toán và mô hình toán học. Trong bài viết này, xulysolieu.info (Xử lý số liệu) sẽ giúp bạn hiểu bậc của đa thức là gì theo cách dễ nhớ, kèm hướng dẫn xác định nhanh, ví dụ minh họa và các lưu ý thường khiến học sinh nhầm lẫn.

1) Bậc của đa thức là gì?

Để trả lời bậc là gì một cách đơn giản: bậc của đa thức là số mũ cao nhất của biến trong đa thức đó sau khi đã thu gọn. Đây là quy tắc quan trọng nhất khi bạn cần xác định bậc là gì trong một biểu thức toán học.

Ví dụ, với đa thức P(x) = 6x3 + 5x2 + 2x − 4, số mũ lớn nhất của x là 3, nên bậc của đa thức là 3. Khi bạn nắm được bậc là gì, bạn sẽ hiểu vì sao đa thức này được gọi là đa thức bậc ba.

Cần lưu ý: khái niệm bậc là gì chỉ được xác định rõ ràng khi đa thức đã ở dạng thu gọn. Nếu các số hạng cùng bậc chưa gộp lại, bạn có thể kết luận sai.

2) Bậc đa thức có ý nghĩa gì?

Trong đại số, bậc đa thức không chỉ là con số để “gọi tên” mà còn mang nhiều ý nghĩa thực tế trong phân tích toán và mô hình toán học. Khi hiểu bậc là gì, bạn sẽ thấy bậc giúp:

- Đánh giá độ phức tạp của biểu thức toán học: đa thức bậc càng cao thường càng khó xử lý và có nhiều dạng biến thiên hơn.

- Dự đoán hình dạng đồ thị hàm số: bậc quyết định kiểu đồ thị (đường thẳng, parabol, hay đường cong phức tạp).

- Ước lượng số nghiệm tối đa của phương trình: phương trình bậc n có tối đa n nghiệm (tính theo số nghiệm thực/phức tùy ngữ cảnh).

Nói cách khác, hiểu bậc là gì giúp bạn nhìn nhanh được “tính chất” của bài toán trước khi bắt tay giải.

3) Cách xác định nhanh bậc là gì trong một đa thức một biến

Muốn xác định bậc là gì một cách chắc chắn, bạn nên theo đúng 2 bước sau:

Bước 1: Thu gọn và sắp xếp đa thức

Nếu đa thức có các số hạng cùng loại, hãy cộng/trừ chúng để đưa về dạng gọn. Sau đó sắp xếp theo lũy thừa giảm dần của biến để dễ nhìn.

Ví dụ: 3x + 4x2 − 7 + 5x3 → 5x3 + 4x2 + 3x − 7.

Bước 2: Xác định số mũ lớn nhất của biến

Số mũ lớn nhất chính là bậc của đa thức. Trong ví dụ trên, số mũ lớn nhất là 3 nên bậc là gì ở đây? Đó là bậc 3.

Chỉ với hai bước này, bạn có thể xác định bậc là gì nhanh và hạn chế sai sót khi làm bài.

4) Hệ số cao nhất và hệ số tự do liên quan gì đến bậc?

Khi nhắc đến bậc là gì, bạn thường đi kèm hai khái niệm quan trọng:

- Hệ số cao nhất: hệ số của số hạng có bậc lớn nhất. Ví dụ 5x3 + 4x2 + 3x − 7 thì hệ số cao nhất là 5.

- Hệ số tự do: số hạng không chứa biến. Trong ví dụ trên, hệ số tự do là −7.

Việc xác định đúng hệ số cao nhất giúp bạn làm tốt các bài về đồ thị, giới hạn, hoặc suy luận dạng hàm trong mô hình toán học. Vì vậy, hiểu bậc là gì nên đi kèm hiểu vai trò của hệ số cao nhất.

5) Các trường hợp đặc biệt bạn phải nhớ

Nhiều bạn trả lời bậc là gì đúng ở đa thức cơ bản nhưng lại sai ở trường hợp đặc biệt. Dưới đây là các quy tắc bắt buộc nhớ:

- Một số khác 0 (ví dụ 7, −3, 0,5) được xem là đa thức bậc 0.

- Đa thức bằng 0 (mọi hệ số đều bằng 0) không có bậc.

Những quy tắc này tuy ngắn nhưng rất hay xuất hiện trong bài kiểm tra, nên bạn cần chắc ngay khi học bậc là gì.

6) Ví dụ minh họa bậc là gì (dễ hiểu, sát chương trình)

Ví dụ 1

Cho đa thức: 3x + 4x2 − 7 + 5x3.

Thu gọn và sắp xếp: 5x3 + 4x2 + 3x − 7.

Số mũ lớn nhất là 3, vậy bậc là gì? Đa thức này có bậc 3.

Ví dụ 2

Cho đa thức: 7x4 + 2x − 6x5 − 3.

Sắp xếp: −6x5 + 7x4 + 2x − 3.

Số mũ lớn nhất là 5, vậy bậc là gì? Đa thức này là bậc 5.

Ví dụ 3 (thu gọn trước khi kết luận)

Cho: B(x) = 6x3 + 4x2 − 5 + 7x3 − x.

Thu gọn: B(x) = 13x3 + 4x2 − x − 5.

Số mũ lớn nhất là 3, vậy bậc là gì? B(x) là đa thức bậc 3.

Ba ví dụ trên cho thấy: nếu bạn bỏ qua bước thu gọn, bạn có thể xác định bậc là gì sai trong các bài có nhiều số hạng trùng bậc.

7) Bậc là gì trong đa thức nhiều biến?

Với đa thức nhiều biến, bậc không chỉ là “số mũ cao nhất của một biến” mà được tính theo tổng số mũ của các biến trong từng đơn thức, rồi lấy tổng lớn nhất. Đây là điểm dễ nhầm khi học bậc là gì ở cấp độ nâng cao hơn.

Ví dụ: P(x, y) = 2x2y4 + 3xy + 5.

- Đơn thức 2x2y4 có tổng số mũ: 2 + 4 = 6.

- Đơn thức 3xy có tổng số mũ: 1 + 1 = 2.

- Hằng số 5 có tổng số mũ: 0.

Tổng lớn nhất là 6, vậy bậc là gì? Đa thức này có bậc 6.

Trong mô hình toán học, đa thức nhiều biến xuất hiện khi bạn mô tả hiện tượng phụ thuộc nhiều yếu tố, nên hiểu bậc là gì sẽ giúp bạn đánh giá mức độ phức tạp của mô hình.

8) Ứng dụng của bậc đa thức trong học tập và mô hình toán học

Nắm vững bậc là gì giúp bạn ứng dụng ngay trong nhiều mảng:

- Giải phương trình: bậc cho biết “mức tối đa” của số nghiệm, từ đó chọn phương pháp giải phù hợp.

- Phân tích hàm số và đồ thị: bậc 1 thường cho đường thẳng, bậc 2 cho parabol, bậc 3 trở lên thường có dạng cong phức tạp hơn.

- Phân tích toán trong thực tế: bậc cao thường thể hiện mô hình linh hoạt hơn nhưng cũng dễ gây quá khớp nếu áp dụng vào dữ liệu.

Dù bạn học đại số ở trường hay ứng dụng vào phân tích dữ liệu, hiểu bậc là gì luôn là kiến thức nền đáng đầu tư.

9) Lưu ý dễ sai khi xác định bậc là gì

- Không thu gọn đa thức trước khi kết luận bậc.

- Nhầm bậc của đa thức nhiều biến với số mũ cao nhất của một biến đơn lẻ.

- Quên trường hợp đặc biệt: số khác 0 là bậc 0; đa thức 0 không có bậc.

Chỉ cần nhớ 3 lưu ý này, bạn sẽ giảm phần lớn lỗi sai khi làm bài về bậc là gì.

10) Kết luận

Bậc là gì? Trong đa thức một biến, bậc là số mũ cao nhất của biến sau khi thu gọn trong đa thức nhiều biến, bậc là tổng số mũ lớn nhất của các biến trong một đơn thức. Hiểu đúng bậc là gì sẽ giúp bạn học tốt đại số, làm bài nhanh hơn và áp dụng hiệu quả trong phân tích toán cũng như mô hình toán học.

Nếu bạn cần hỗ trợ giải bài tập, kiểm tra đáp án, hoặc muốn hệ thống kiến thức đại số theo hướng dễ hiểu, hãy liên hệ xulysolieu.info (Xử lý số liệu) qua số 0878968468.

Xây dựng khung lý thuyết trong nghiên cứu khoa học: Hướng dẫn từ A–Z

Trong quá trình thực hiện nghiên cứu khoa học, đặc biệt là khóa luận, luận văn hay bài báo học thuật, một trong những nội dung khiến người học gặp nhiều lúng túng nhất chính là xây dựng khung lý thuyết. Việc hiểu chưa đúng khung lý thuyết trong nghiên cứu khoa học sẽ dẫn đến mô hình nghiên cứu rời rạc, giả thuyết thiếu cơ sở và phân tích dữ liệu kém thuyết phục. Bài viết này giúp bạn hiểu rõ bản chất, vai trò và cách xây dựng khung lý thuyết trong nghiên cứu khoa học một cách hệ thống, dễ áp dụng và đúng chuẩn học thuật.

Khung lý thuyết trong nghiên cứu khoa học là gì?

Khung lý thuyết trong nghiên cứu khoa học là hệ thống các khái niệm, biến số và mối quan hệ giữa chúng được xây dựng nhằm giải thích, mô tả hoặc dự đoán một hiện tượng nghiên cứu cụ thể. Nói cách khác, khung lý thuyết trong nghiên cứu khoa học đóng vai trò như “xương sống” định hướng toàn bộ nội dung nghiên cứu.

Một khung lý thuyết tốt sẽ giúp nhà nghiên cứu xác định rõ vấn đề cần nghiên cứu, lựa chọn biến độc lập, biến phụ thuộc và lý giải mối quan hệ giữa các biến dựa trên nền tảng lý thuyết đã được công nhận.

Vai trò của khung lý thuyết trong nghiên cứu khoa học

Khung lý thuyết trong nghiên cứu khoa học không chỉ mang tính hình thức mà có vai trò cốt lõi trong toàn bộ quy trình nghiên cứu. Trước hết, khung lý thuyết giúp làm rõ phạm vi nghiên cứu, tránh lan man và thiếu trọng tâm.

Thứ hai, khung lý thuyết trong nghiên cứu khoa học là cơ sở để xây dựng mô hình khái niệm và các giả thuyết nghiên cứu. Mỗi giả thuyết đều cần được lý giải bằng lý thuyết, thay vì dựa trên cảm tính.

Cuối cùng, khung lý thuyết giúp định hướng phương pháp nghiên cứu, cách đo lường biến và phương pháp phân tích dữ liệu. Nếu khung lý thuyết không rõ ràng, các bước nghiên cứu sau đó rất dễ sai lệch.

Khung lý thuyết và mô hình khái niệm

Trong nghiên cứu khoa học, khung lý thuyết thường được thể hiện trực quan dưới dạng mô hình khái niệm. Mô hình khái niệm là hình ảnh hóa của khung lý thuyết, thể hiện các biến độc lập, biến phụ thuộc và mối quan hệ giả định giữa chúng.

Tuy nhiên, cần lưu ý rằng khung lý thuyết trong nghiên cứu khoa học không chỉ là một sơ đồ. Bản chất của khung lý thuyết nằm ở lập luận khoa học giải thích vì sao các biến có mối liên hệ với nhau.

Các thành phần cơ bản của khung lý thuyết

Một khung lý thuyết trong nghiên cứu khoa học thường bao gồm các thành phần chính sau:

- Các khái niệm và lý thuyết nền tảng liên quan đến đề tài.

- Biến độc lập: các yếu tố được giả định là nguyên nhân hoặc yếu tố tác động.

- Biến phụ thuộc: kết quả hoặc hiện tượng cần được giải thích.

- Các mối quan hệ giả định giữa các biến.

Việc xác định đúng các thành phần này giúp khung lý thuyết trong nghiên cứu khoa học trở nên rõ ràng, logic và dễ kiểm định.

Biến độc lập và biến phụ thuộc trong khung lý thuyết

Biến độc lập là những yếu tố được cho là ảnh hưởng đến hiện tượng nghiên cứu. Trong khi đó, biến phụ thuộc là kết quả chịu tác động của các biến độc lập.

Trong khung lý thuyết trong nghiên cứu khoa học, mối quan hệ giữa biến độc lập và biến phụ thuộc cần được giải thích dựa trên các nghiên cứu trước hoặc lý thuyết đã được kiểm chứng. Điều này giúp nghiên cứu có tính kế thừa và giá trị khoa học.

Quy trình xây dựng khung lý thuyết trong nghiên cứu khoa học

Để xây dựng khung lý thuyết trong nghiên cứu khoa học một cách bài bản, bạn có thể thực hiện theo các bước sau:

- Xác định vấn đề nghiên cứu và mục tiêu nghiên cứu.

- Tổng quan các nghiên cứu và lý thuyết liên quan.

- Lựa chọn các lý thuyết phù hợp làm nền tảng.

- Xác định biến độc lập, biến phụ thuộc và các mối quan hệ.

- Trình bày khung lý thuyết bằng mô hình khái niệm và lập luận.

Quy trình này giúp đảm bảo khung lý thuyết trong nghiên cứu khoa học được xây dựng có cơ sở, logic và nhất quán.

Ví dụ minh họa về khung lý thuyết trong nghiên cứu khoa học

Giả sử bạn nghiên cứu các yếu tố ảnh hưởng đến sự hài lòng của khách hàng. Trong trường hợp này, biến phụ thuộc là sự hài lòng, còn biến độc lập có thể bao gồm chất lượng dịch vụ, giá cả, hình ảnh thương hiệu và trải nghiệm khách hàng.

Khung lý thuyết trong nghiên cứu khoa học sẽ giải thích vì sao từng yếu tố này có thể tác động đến sự hài lòng dựa trên các lý thuyết marketing và hành vi người tiêu dùng.

Khung lý thuyết trong nghiên cứu định lượng và định tính

Trong nghiên cứu định lượng, khung lý thuyết trong nghiên cứu khoa học thường được xây dựng rõ ràng ngay từ đầu để phục vụ việc kiểm định giả thuyết. Trong khi đó, nghiên cứu định tính có thể sử dụng khung lý thuyết linh hoạt hơn, thậm chí được điều chỉnh trong quá trình nghiên cứu.

Dù ở loại hình nghiên cứu nào, khung lý thuyết vẫn đóng vai trò định hướng và giúp nghiên cứu có cấu trúc khoa học.

Những lỗi thường gặp khi xây dựng khung lý thuyết

Nhiều người học mắc phải các lỗi phổ biến khi xây dựng khung lý thuyết trong nghiên cứu khoa học như:

- Nhầm lẫn giữa khung lý thuyết và cơ sở lý thuyết.

- Chỉ vẽ mô hình khái niệm mà không có lập luận lý thuyết.

- Đưa quá nhiều biến không cần thiết vào mô hình.

- Khung lý thuyết không gắn với phương pháp nghiên cứu.

Việc tránh những lỗi này sẽ giúp khung lý thuyết trong nghiên cứu khoa học trở nên chặt chẽ và có giá trị hơn.

Mối liên hệ giữa khung lý thuyết và phương pháp nghiên cứu

Khung lý thuyết trong nghiên cứu khoa học có mối liên hệ chặt chẽ với phương pháp nghiên cứu. Tùy vào cấu trúc khung lý thuyết, nhà nghiên cứu sẽ lựa chọn phương pháp định lượng, định tính hoặc kết hợp.

Ví dụ, nếu khung lý thuyết gồm nhiều biến độc lập và biến phụ thuộc rõ ràng, các phương pháp phân tích dữ liệu như hồi quy, ANOVA hay SEM thường được áp dụng.

Hỗ trợ xây dựng khung lý thuyết và xử lý số liệu

Nếu bạn gặp khó khăn trong việc xây dựng khung lý thuyết trong nghiên cứu khoa học, xác định biến độc lập, biến phụ thuộc hoặc thiết kế mô hình khái niệm phù hợp, bạn có thể tham khảo dịch vụ tại xulysolieu.info – Xử lý số liệu. Đội ngũ hỗ trợ tập trung vào việc hướng dẫn logic nghiên cứu và phân tích dữ liệu theo đúng chuẩn học thuật.

Kết luận

Khung lý thuyết trong nghiên cứu khoa học là nền tảng giúp nghiên cứu có định hướng rõ ràng, logic và có cơ sở khoa học vững chắc. Việc hiểu đúng và xây dựng đúng khung lý thuyết trong nghiên cứu khoa học sẽ giúp bạn triển khai đề tài hiệu quả, phân tích dữ liệu chính xác và nâng cao giá trị học thuật của nghiên cứu. Đây là bước không thể thiếu đối với bất kỳ nghiên cứu khoa học nghiêm túc nào.

Hồi quy đa biến là gì? Cách phân tích và diễn giải kết quả trong SPSS

Trong nghiên cứu định lượng và phân tích dữ liệu, hồi quy đa biến là một trong những kỹ thuật quan trọng và được sử dụng nhiều nhất. Phương pháp này cho phép nhà nghiên cứu đánh giá đồng thời tác động của nhiều yếu tố lên một kết quả cụ thể, từ đó đưa ra kết luận khoa học và có cơ sở. Tuy nhiên, nếu không nắm chắc bản chất, quy trình và cách đọc kết quả, việc áp dụng hồi quy đa biến trong SPSS rất dễ dẫn đến sai sót. Bài viết này sẽ giúp bạn hiểu rõ hồi quy đa biến là gì, vai trò của nó, các giả định cần kiểm tra và cách phân tích, diễn giải kết quả một cách logic, dễ hiểu.

Hồi quy đa biến là gì?

Hồi quy đa biến (multiple regression) là phương pháp thống kê dùng để mô hình hóa mối quan hệ tuyến tính giữa một biến phụ thuộc và từ hai biến độc lập trở lên. Mục tiêu của hồi quy đa biến là xác định mức độ ảnh hưởng của từng yếu tố khi các yếu tố khác được giữ không đổi.

So với hồi quy tuyến tính đơn, hồi quy đa biến phản ánh tốt hơn tính phức tạp của dữ liệu thực tế, nơi một kết quả thường chịu tác động đồng thời từ nhiều nguyên nhân. Vì vậy, hồi quy đa biến được xem là nền tảng của nhiều mô hình phân tích dữ liệu nâng cao trong kinh tế, y học, marketing và khoa học xã hội.

Dạng tổng quát của mô hình hồi quy đa biến được viết như sau:

Y = β₀ + β₁X₁ + β₂X₂ + … + βₚXₚ + ε

Trong đó, Y là biến phụ thuộc, X₁ đến Xₚ là các biến độc lập, β₀ là hằng số, βᵢ là hệ số hồi quy và ε là sai số ngẫu nhiên.

Ý nghĩa và vai trò của hồi quy đa biến

Hồi quy đa biến giữ vai trò trung tâm trong phân tích dữ liệu vì nó cho phép nhà nghiên cứu:

- Định lượng mức độ ảnh hưởng của từng yếu tố lên biến kết quả.

- Kiểm định các giả thuyết nghiên cứu một cách khoa học.

- Dự báo giá trị của biến phụ thuộc dựa trên các biến giải thích.

- Hỗ trợ ra quyết định dựa trên bằng chứng dữ liệu.

Trong thực tế, hồi quy đa biến được ứng dụng rộng rãi như dự đoán doanh số bán hàng dựa trên chi phí marketing, đánh giá mức độ hài lòng của khách hàng dựa trên chất lượng dịch vụ hay phân tích kết quả học tập dựa trên nhiều yếu tố cá nhân.

Các chỉ số quan trọng trong hồi quy đa biến

Khi thực hiện hồi quy đa biến trong SPSS, bạn cần đặc biệt chú ý đến các chỉ số sau:

Hệ số tương quan R và R²

R phản ánh mức độ liên hệ tuyến tính giữa các biến độc lập và biến phụ thuộc. R² cho biết tỷ lệ biến thiên của Y được giải thích bởi mô hình hồi quy. R² càng cao thì mô hình hồi quy càng phù hợp với dữ liệu.

Hệ số hồi quy Beta

Hệ số Beta cho biết chiều hướng và mức độ ảnh hưởng của từng biến độc lập lên biến phụ thuộc. Khi so sánh mức độ ảnh hưởng giữa các biến có đơn vị đo khác nhau, cần sử dụng hệ số Beta chuẩn hóa.

Giá trị p (Sig.)

Giá trị p giúp kiểm định ý nghĩa thống kê của từng biến độc lập. Nếu p < 0,05, biến đó có ảnh hưởng đáng kể đến biến phụ thuộc trong mô hình hồi quy.

Các giả định của mô hình hồi quy đa biến

Để kết quả hồi quy đa biến đáng tin cậy, mô hình cần thỏa mãn các giả định cơ bản:

- Mối quan hệ tuyến tính giữa biến phụ thuộc và các biến độc lập.

- Các quan sát độc lập với nhau.

- Sai số có phân phối chuẩn với trung bình bằng 0.

- Phương sai của sai số đồng nhất.

- Không tồn tại đa cộng tuyến nghiêm trọng giữa các biến độc lập.

Nếu các giả định này bị vi phạm, kết luận từ hồi quy đa biến có thể bị sai lệch hoặc kém tin cậy.

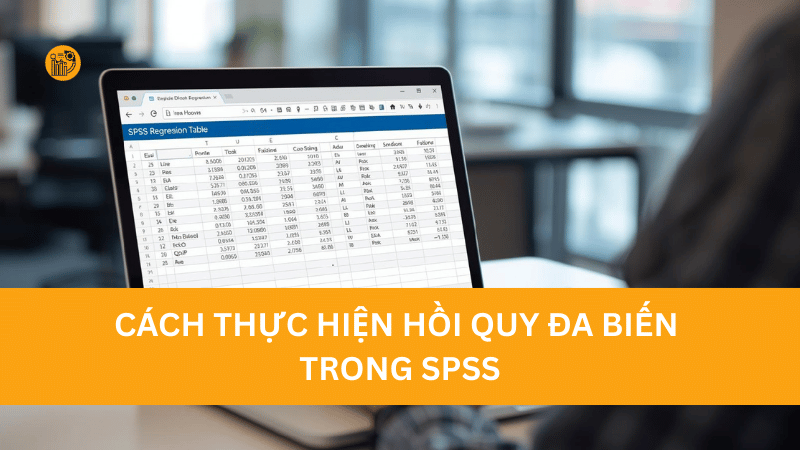

Cách thực hiện hồi quy đa biến trong SPSS

Để chạy hồi quy đa biến trong SPSS, bạn thực hiện theo các bước cơ bản sau:

- Vào menu Analyze → Regression → Linear.

- Đưa biến phụ thuộc vào ô Dependent.

- Đưa các biến độc lập vào ô Independent(s).

- Trong mục Statistics, chọn Collinearity diagnostics để kiểm tra đa cộng tuyến.

- Nhấn OK để chạy mô hình.

Sau khi chạy xong, SPSS sẽ trả về các bảng kết quả quan trọng để bạn phân tích.

Đọc và diễn giải bảng Model Summary

Bảng Model Summary cung cấp các chỉ số như R, R² và Adjusted R². Trong đó, Adjusted R² thường được ưu tiên sử dụng vì đã hiệu chỉnh theo số lượng biến độc lập, giúp đánh giá mô hình hồi quy chính xác hơn.

Ví dụ, Adjusted R² = 0,70 cho thấy mô hình hồi quy đa biến giải thích được 70% sự biến thiên của biến phụ thuộc.

Đọc và diễn giải bảng ANOVA

Bảng ANOVA dùng để kiểm định độ phù hợp tổng thể của mô hình hồi quy. Kiểm định F trong bảng này giúp xác định liệu mô hình có ý nghĩa thống kê hay không.

Nếu giá trị Sig. trong bảng ANOVA nhỏ hơn 0,05, bạn có thể kết luận mô hình hồi quy đa biến là phù hợp với dữ liệu.

Đọc và diễn giải bảng Coefficients

Bảng Coefficients cho biết hệ số hồi quy, giá trị t và Sig. của từng biến độc lập. Dựa vào bảng này, bạn xác định:

- Biến nào có ảnh hưởng đáng kể đến biến phụ thuộc.

- Chiều hướng ảnh hưởng là cùng chiều hay ngược chiều.

- Mức độ ảnh hưởng tương đối thông qua hệ số Beta chuẩn hóa.

Đa cộng tuyến trong hồi quy đa biến

Đa cộng tuyến xảy ra khi các biến độc lập có tương quan cao với nhau, làm sai lệch ước lượng của mô hình hồi quy. Trong SPSS, hiện tượng này thường được phát hiện thông qua chỉ số VIF.

Nếu VIF lớn hơn 5 hoặc 10, mô hình có nguy cơ đa cộng tuyến và cần được điều chỉnh bằng cách loại bớt biến, gộp biến hoặc sử dụng các kỹ thuật hồi quy điều chuẩn.

Đánh giá chất lượng mô hình hồi quy

Để đánh giá toàn diện mô hình hồi quy đa biến, bạn nên kết hợp nhiều tiêu chí như R², Adjusted R², kiểm định F, kiểm định t và phân tích đồ thị phần dư. Cách tiếp cận này giúp đảm bảo mô hình vừa phù hợp về mặt thống kê vừa có giá trị ứng dụng.

Hỗ trợ phân tích hồi quy và xử lý số liệu

Nếu bạn gặp khó khăn trong việc xây dựng mô hình hồi quy, kiểm tra giả định hay diễn giải kết quả phân tích dữ liệu, bạn có thể tham khảo dịch vụ tại [xulysolieu.info](https://xulysolieu.info/) – Xử lý số liệu. Đội ngũ hỗ trợ tập trung vào việc hướng dẫn bản chất thống kê và thực hành SPSS một cách bài bản.

Liên hệ: 0878968468

Kết luận

Hồi quy đa biến là công cụ cốt lõi giúp phân tích mối quan hệ giữa nhiều yếu tố và một kết quả trong nghiên cứu định lượng. Khi hiểu rõ khái niệm, giả định, quy trình thực hiện và cách đọc kết quả trong SPSS, bạn sẽ khai thác được tối đa sức mạnh của mô hình hồi quy, từ đó nâng cao chất lượng phân tích dữ liệu và độ tin cậy của nghiên cứu.

Cách tính phương sai và độ lệch chuẩn: Công thức tính, ý nghĩa và ví dụ dễ hiểu

Trong phân tích thống kê, nếu bạn chỉ nhìn vào “giá trị trung bình” thì vẫn chưa đủ để hiểu dữ liệu. Hai tập dữ liệu có cùng trung bình có thể khác nhau hoàn toàn về mức độ phân tán. Đó là lý do vì sao cách tính phương sai và độ lệch chuẩn trở thành kỹ năng nền tảng trong học tập và làm việc với dữ liệu định lượng. Bài viết này từ xulysolieu.info (Xử lý số liệu) sẽ hướng dẫn cách tính phương sai và độ lệch chuẩn theo đúng công thức, giải thích ý nghĩa, kèm ví dụ minh họa và bài tập tự luyện để bạn nắm chắc bản chất.

1) Phương sai và độ lệch chuẩn là gì?

Trước khi đi vào cách tính phương sai và độ lệch chuẩn, bạn cần hiểu bản chất của hai chỉ số này:

- Phương sai (variance) đo mức độ phân tán của dữ liệu quanh giá trị trung bình. Phương sai càng lớn, dữ liệu càng “dao động” mạnh và ít tập trung.

- Độ lệch chuẩn (standard deviation) là căn bậc hai của phương sai, có cùng đơn vị với dữ liệu gốc nên dễ diễn giải hơn.

Trong dữ liệu định lượng, cách tính phương sai và độ lệch chuẩn giúp bạn trả lời nhanh: dữ liệu có ổn định không, mức độ biến động có cao không, và nhóm nào phân tán hơn.

2) Khi nào nên dùng cách tính phương sai và độ lệch chuẩn?

Trong phân tích thống kê, cách tính phương sai và độ lệch chuẩn thường được sử dụng khi bạn cần:

- So sánh mức độ biến động giữa hai nhóm dữ liệu định lượng.

- Đánh giá độ ổn định của điểm số, doanh thu, thời gian hoàn thành, cân nặng, nhiệt độ…

- Chuẩn bị dữ liệu cho các bước phân tích sâu hơn như hồi quy, kiểm định, mô hình hóa.

Nắm chắc cách tính phương sai và độ lệch chuẩn giúp bạn tránh đánh giá sai dữ liệu chỉ vì nhìn vào trung bình.

3) Cách tính phương sai và độ lệch chuẩn với mẫu số liệu rời rạc

Giả sử bạn có mẫu số liệu gồm n giá trị: x1, x2, …, xn. Ký hiệu trung bình mẫu là x̄.

3.1 Công thức phương sai mẫu

Trong chương trình học phổ thông và thống kê cơ bản, phương sai mẫu (ký hiệu S2) được tính bằng:

S2 = (1/n) × [(x1 − x̄)2 + (x2 − x̄)2 + … + (xn − x̄)2]

Đây là công thức cốt lõi trong cách tính phương sai và độ lệch chuẩn: bạn lấy từng giá trị trừ trung bình, bình phương, rồi cộng lại và chia cho n.

3.2 Công thức độ lệch chuẩn

Độ lệch chuẩn S là căn bậc hai của phương sai:

S = √(S2)

Trong cách tính phương sai và độ lệch chuẩn, độ lệch chuẩn thường được ưu tiên khi diễn giải vì nó cùng đơn vị với dữ liệu.

3.3 Công thức biến đổi để tính nhanh

Để tính nhanh hơn, bạn có thể dùng công thức biến đổi:

S2 = (1/n) × (x12 + x22 + … + xn2) − x̄2

Công thức này rất hữu ích khi bạn làm phân tích thống kê với dữ liệu định lượng có nhiều giá trị.

3.4 Phương sai hiệu chỉnh

Trong thống kê ứng dụng, người ta còn dùng phương sai hiệu chỉnh (thường ký hiệu ŝ2) để ước lượng phương sai tổng thể từ mẫu:

ŝ2 = (1/(n − 1)) × [(x1 − x̄)2 + … + (xn − x̄)2]

Đây cũng là một phần quan trọng khi học cách tính phương sai và độ lệch chuẩn, nhất là trong các môn thống kê và xác suất.

4) Cách tính phương sai và độ lệch chuẩn khi dữ liệu ở dạng bảng tần số

Nhiều trường hợp dữ liệu định lượng được tổng hợp dưới dạng bảng tần số. Khi đó, ta có các giá trị x1, x2, …, xk với tần số tương ứng n1, n2, …, nk và n = n1 + n2 + … + nk.

4.1 Công thức phương sai theo bảng tần số

S2 = (1/n) × [n1(x1 − x̄)2 + n2(x2 − x̄)2 + … + nk(xk − x̄)2]

4.2 Công thức biến đổi theo bảng tần số

S2 = (1/n) × (n1x12 + n2x22 + … + nkxk2) − x̄2

Trong thực hành, đây là cách tính phương sai và độ lệch chuẩn rất phổ biến khi bạn làm bài tập thống kê mô tả hoặc tổng hợp dữ liệu khảo sát.

5) Ví dụ minh họa cách tính phương sai và độ lệch chuẩn

Ví dụ 1: Điểm Toán của 10 học sinh

Dữ liệu: 10; 9; 5; 6; 1; 5; 7; 9; 5; 6.

Bước 1: Tính trung bình:

x̄ = (10 + 9 + 5 + 6 + 1 + 5 + 7 + 9 + 5 + 6) / 10 = 6,3

Bước 2: Áp dụng cách tính phương sai và độ lệch chuẩn bằng công thức:

S2 = (1/10) × [ (10−6,3)2 + 2(9−6,3)2 + (7−6,3)2 + 2(6−6,3)2 + 3(5−6,3)2 + (1−6,3)2 ]

Kết quả: S2 = 6,21

Bước 3: Tính độ lệch chuẩn:

S = √6,21 ≈ 2,492

Qua ví dụ này, cách tính phương sai và độ lệch chuẩn cho thấy điểm số phân tán tương đối quanh trung bình 6,3.

Ví dụ 2: Cân nặng của 10 sinh viên

Dữ liệu (kg): 59,0; 45,5; 52,7; 47,9; 40,7; 48,3; 52,1; 43,1; 55,2; 45,3.

Bước 1: Trung bình:

x̄ = (tổng 10 giá trị) / 10 = 48,98

Bước 2: Phương sai theo cách tính phương sai và độ lệch chuẩn:

S2 = 29,3076

Bước 3: Độ lệch chuẩn:

S = √29,3076 ≈ 5,4136

Diễn giải: độ lệch chuẩn khoảng 5,41 kg cho thấy cân nặng trong nhóm dao động khá rõ.

6) Ý nghĩa của phương sai và độ lệch chuẩn trong phân tích thống kê

Hiểu cách tính phương sai và độ lệch chuẩn là một chuyện, nhưng diễn giải đúng mới là phần quan trọng trong phân tích dữ liệu định lượng:

- Phương sai lớn: dữ liệu phân tán mạnh, độ ổn định thấp.

- Phương sai nhỏ: dữ liệu tập trung quanh trung bình, ổn định hơn.

- Độ lệch chuẩn cho biết mức “lệch điển hình” so với trung bình.

Trong variance và standard deviation, độ lệch chuẩn thường được dùng để so sánh mức biến động giữa các tập dữ liệu có cùng đơn vị đo.

7) Bài tập tự luyện (kèm gợi ý cách làm)

Dưới đây là các bài tập giúp bạn luyện cách tính phương sai và độ lệch chuẩn. Khi làm, hãy theo 3 bước chuẩn: tính trung bình → tính phương sai → lấy căn để ra độ lệch chuẩn.

- Bài 1: Dữ liệu điểm giữa kỳ theo bảng tần số (nhiều mức điểm và số sinh viên tương ứng). Tính phương sai mẫu và độ lệch chuẩn. Gợi ý: Dùng công thức theo bảng tần số để rút gọn phép tính.

- Bài 2: Bảng số liệu điểm theo thang 4 và số môn tương ứng. Tính phương sai mẫu và độ lệch chuẩn. Gợi ý: Tính x̄ bằng trung bình có trọng số theo tần số.

- Bài 3: Số huy chương vàng qua các năm 2015–2019. Tính phương sai của dãy số liệu. Gợi ý: Đây là dữ liệu rời rạc, dùng công thức S2 với n = 5.

- Bài 4: Nhiệt độ trung bình Nam Định giai đoạn 2010–2019. Tính phương sai mẫu và độ lệch chuẩn. Gợi ý: Cẩn thận khi bình phương số thập phân, có thể dùng công thức biến đổi để tính nhanh.

- Bài 5: Đánh giá sản phẩm trên Shopee theo mức sao và số lượt. Tính phương sai mẫu và độ lệch chuẩn. Gợi ý: Đây là bảng tần số, dùng công thức theo tần số để tính nhanh.

Luyện đều các bài này sẽ giúp bạn nắm vững cách tính phương sai và độ lệch chuẩn trong nhiều dạng dữ liệu định lượng khác nhau.

8) Kết luận

Cách tính phương sai và độ lệch chuẩn là kiến thức trọng tâm trong phân tích thống kê và làm việc với dữ liệu định lượng. Phương sai (variance) phản ánh mức độ phân tán của dữ liệu quanh trung bình, còn độ lệch chuẩn (standard deviation) giúp diễn giải mức dao động theo đúng đơn vị gốc. Khi bạn nắm chắc cách tính phương sai và độ lệch chuẩn, việc đọc bảng số liệu, so sánh nhóm và phân tích dữ liệu sẽ rõ ràng và chính xác hơn.

Nếu bạn cần hỗ trợ tính toán, kiểm tra kết quả, hướng dẫn giải bài tập hoặc ứng dụng cách tính phương sai và độ lệch chuẩn vào báo cáo phân tích thống kê, hãy liên hệ xulysolieu.info (Xử lý số liệu) qua số 0878968468.

Khung lý thuyết nghiên cứu là gì? So sánh chi tiết với cơ sở lý thuyết

Trong quá trình thực hiện nghiên cứu khoa học, đặc biệt là các đề tài định lượng, luận văn, khóa luận hay bài báo khoa học, người học thường gặp hai khái niệm dễ gây nhầm lẫn: khung lý thuyết nghiên cứu và cơ sở lý thuyết. Việc hiểu chưa đúng hoặc sử dụng lẫn lộn hai nội dung này có thể khiến cấu trúc nghiên cứu thiếu logic, mô hình phân tích không rõ ràng và khó thuyết phục. Bài viết này sẽ giúp bạn hiểu đúng khung lý thuyết nghiên cứu là gì, vai trò của nó trong nghiên cứu khoa học và phân biệt chi tiết với cơ sở lý thuyết một cách dễ hiểu, mang tính ứng dụng cao.

Khung lý thuyết nghiên cứu là gì?

Khung lý thuyết nghiên cứu là một hệ thống các khái niệm, biến nghiên cứu và mối quan hệ giữa chúng được xây dựng nhằm giải thích hiện tượng hoặc vấn đề nghiên cứu cụ thể. Nói cách khác, khung lý thuyết nghiên cứu đóng vai trò như “bản đồ tư duy” định hướng toàn bộ quá trình nghiên cứu từ đặt câu hỏi, xây dựng giả thuyết đến lựa chọn phương pháp nghiên cứu và phân tích dữ liệu.

Một khung lý thuyết nghiên cứu thường được trình bày dưới dạng mô hình nghiên cứu, trong đó thể hiện rõ biến độc lập, biến phụ thuộc và các mối quan hệ giả định giữa các biến. Khung lý thuyết nghiên cứu không phải là tập hợp lý thuyết chung chung, mà là sự chọn lọc và kết nối các yếu tố lý thuyết phù hợp nhất với mục tiêu nghiên cứu.

Vai trò của khung lý thuyết nghiên cứu trong nghiên cứu khoa học

Khung lý thuyết nghiên cứu giữ vai trò trung tâm trong một đề tài khoa học. Trước hết, nó giúp nhà nghiên cứu xác định rõ biến nghiên cứu nào cần đưa vào mô hình và loại bỏ những yếu tố không liên quan. Điều này giúp nghiên cứu có trọng tâm, tránh lan man và thiếu kiểm soát.

Thứ hai, khung lý thuyết nghiên cứu là cơ sở để xây dựng giả thuyết nghiên cứu. Mỗi mối quan hệ trong mô hình nghiên cứu đều cần được lý giải dựa trên lập luận lý thuyết rõ ràng. Nếu không có khung lý thuyết nghiên cứu, giả thuyết sẽ mang tính chủ quan và thiếu cơ sở khoa học.

Cuối cùng, khung lý thuyết nghiên cứu định hướng việc lựa chọn phương pháp nghiên cứu, cách thu thập dữ liệu và kỹ thuật phân tích phù hợp. Một khung lý thuyết nghiên cứu tốt sẽ giúp quá trình xử lý số liệu diễn ra logic và nhất quán.

Cơ sở lý thuyết là gì?

Cơ sở lý thuyết là tập hợp các lý thuyết, khái niệm, nguyên lý và kết quả nghiên cứu trước đây có liên quan đến đề tài nghiên cứu. Cơ sở lý thuyết cung cấp nền tảng học thuật giúp người nghiên cứu hiểu sâu về lĩnh vực đang nghiên cứu, đồng thời làm rõ bối cảnh khoa học mà nghiên cứu đang kế thừa.

Khác với khung lý thuyết nghiên cứu, cơ sở lý thuyết không nhằm trực tiếp xây dựng mô hình nghiên cứu cụ thể. Thay vào đó, nó giúp giải thích các khái niệm, định nghĩa biến nghiên cứu và tổng hợp các hướng tiếp cận lý thuyết đã được sử dụng trong các nghiên cứu trước.

Mối quan hệ giữa khung lý thuyết nghiên cứu và cơ sở lý thuyết

Khung lý thuyết nghiên cứu và cơ sở lý thuyết có mối quan hệ chặt chẽ nhưng không đồng nhất. Cơ sở lý thuyết đóng vai trò là nền móng học thuật, còn khung lý thuyết nghiên cứu được xây dựng dựa trên sự chọn lọc từ nền móng đó.

Nói cách khác, cơ sở lý thuyết trả lời câu hỏi “những lý thuyết nào đã tồn tại?”, còn khung lý thuyết nghiên cứu trả lời câu hỏi “nghiên cứu này sẽ sử dụng và kết nối các lý thuyết đó như thế nào để giải thích vấn đề cụ thể?”. Vì vậy, cơ sở lý thuyết thường được trình bày trước, sau đó mới đến khung lý thuyết nghiên cứu.

So sánh khung lý thuyết nghiên cứu và cơ sở lý thuyết

Để tránh nhầm lẫn, bạn có thể phân biệt hai khái niệm này qua một số điểm chính:

- Khung lý thuyết nghiên cứu tập trung vào mô hình nghiên cứu cụ thể, trong khi cơ sở lý thuyết mang tính tổng quan và nền tảng.

- Khung lý thuyết nghiên cứu xác định rõ biến nghiên cứu và mối quan hệ giữa chúng, còn cơ sở lý thuyết giải thích các khái niệm và lý thuyết liên quan.

- Khung lý thuyết nghiên cứu gắn trực tiếp với giả thuyết và phương pháp nghiên cứu, trong khi cơ sở lý thuyết mang tính tham khảo học thuật.

Ví dụ minh họa về khung lý thuyết nghiên cứu

Giả sử bạn thực hiện một nghiên cứu về các yếu tố ảnh hưởng đến hiệu suất làm việc của nhân viên. Trong cơ sở lý thuyết, bạn có thể trình bày các lý thuyết về động lực làm việc, lý thuyết hành vi tổ chức, lý thuyết công nghệ và hiệu suất.

Từ cơ sở lý thuyết đó, bạn xây dựng khung lý thuyết nghiên cứu gồm các biến nghiên cứu như: sử dụng công nghệ thông tin, động lực làm việc, môi trường làm việc và hiệu suất làm việc. Các mối quan hệ giữa các biến này được thể hiện rõ trong mô hình nghiên cứu và là nền tảng để kiểm định bằng dữ liệu thực tế.

Khung lý thuyết nghiên cứu trong nghiên cứu định lượng

Trong nghiên cứu định lượng, khung lý thuyết nghiên cứu càng đóng vai trò quan trọng. Nó giúp xác định rõ biến độc lập, biến phụ thuộc và biến trung gian, từ đó lựa chọn đúng phương pháp nghiên cứu như hồi quy, ANOVA hay mô hình cấu trúc tuyến tính.

Một khung lý thuyết nghiên cứu rõ ràng sẽ giúp quá trình phân tích dữ liệu trở nên mạch lạc, kết quả dễ diễn giải và có giá trị khoa học cao hơn.

Những lỗi thường gặp khi xây dựng khung lý thuyết nghiên cứu

- Nhầm lẫn giữa khung lý thuyết nghiên cứu và cơ sở lý thuyết.

- Xây dựng mô hình nghiên cứu nhưng không dựa trên lập luận lý thuyết.

- Đưa quá nhiều biến nghiên cứu không cần thiết vào mô hình.

- Khung lý thuyết nghiên cứu không liên kết chặt chẽ với phương pháp nghiên cứu.

Việc tránh những lỗi này sẽ giúp nghiên cứu của bạn có cấu trúc khoa học và dễ được chấp nhận hơn.

Hỗ trợ xây dựng khung lý thuyết và xử lý số liệu

Nếu bạn gặp khó khăn trong việc xây dựng khung lý thuyết nghiên cứu, xác định biến nghiên cứu, mô hình nghiên cứu hoặc lựa chọn phương pháp nghiên cứu phù hợp, bạn có thể tham khảo dịch vụ tại xulysolieu.info – Xử lý số liệu. Đội ngũ hỗ trợ tập trung vào việc hướng dẫn logic nghiên cứu và phân tích dữ liệu một cách bài bản.

Kết luận

Khung lý thuyết nghiên cứu là phần cốt lõi giúp định hướng toàn bộ quá trình nghiên cứu khoa học, từ xây dựng giả thuyết đến phân tích dữ liệu. Trong khi đó, cơ sở lý thuyết đóng vai trò nền tảng học thuật giúp hình thành khung lý thuyết nghiên cứu. Việc phân biệt rõ hai khái niệm này không chỉ giúp bài nghiên cứu mạch lạc hơn mà còn nâng cao chất lượng và giá trị khoa học của công trình nghiên cứu.