P-value là gì? Cách tính P và cách đọc kết quả thống kê

Trong phân tích dữ liệu, p-value thường là con số “quyết định” bạn có đủ bằng chứng để bác bỏ giả thuyết không hay chưa. Nhưng nếu chỉ nhìn p-value rồi kết luận nhanh, bạn rất dễ hiểu sai bản chất. Bài viết này đi thẳng vào 3 việc bạn cần nắm: p-value là gì, cách đọc đúng trong kiểm định giả thuyết, và đặc biệt là cách tính p trong thực hành (từ tư duy thống kê đến thao tác trên phần mềm).

Nếu bạn đang học hoặc làm nghiên cứu, mục tiêu không chỉ là biết cách tính p, mà còn là biết p-value đang trả lời câu hỏi nào, và nó liên quan thế nào đến mức ý nghĩa thống kê.

1) P-value là gì và nó nói lên điều gì?

p-value (hay p-value) là xác suất để quan sát được kết quả “ít nhất cực đoan như dữ liệu bạn đang có” nếu giả thuyết không (H0) là đúng. Nói đơn giản: p-value đo mức “khó tin” của dữ liệu dưới góc nhìn H0.

Trong kiểm định giả thuyết, ta thường có:

- H0 (giả thuyết không): không có khác biệt/không có tác động.

- H1/Ha (giả thuyết thay thế): có khác biệt/có tác động.

Khi làm kiểm định, bạn sẽ nhận được p-value và so sánh với mức ý nghĩa thống kê (alpha, ký hiệu α). Quy tắc phổ biến:

- Nếu p-value < α: bác bỏ H0 (kết quả có ý nghĩa thống kê).

- Nếu p-value ≥ α: chưa đủ bằng chứng để bác bỏ H0.

Điểm quan trọng: p-value không cho bạn biết “xác suất H0 đúng”. Nó chỉ cho biết dữ liệu “phù hợp” hay “kém phù hợp” với H0 đến mức nào.

2) Mức ý nghĩa thống kê và cách dùng cho đúng

Mức ý nghĩa thống kê là ngưỡng chấp nhận rủi ro khi bác bỏ H0. Thường gặp nhất là α = 0,05 hoặc 0,01. Khi bạn chọn α = 0,05, nghĩa là bạn chấp nhận khoảng 5% rủi ro kết luận “có khác biệt” trong khi thực tế không có.

Trong thực tế, mức ý nghĩa thống kê cần được chọn trước khi chạy phân tích, và nên gắn với bối cảnh nghiên cứu (y tế thường chặt hơn; nghiên cứu thăm dò có thể linh hoạt hơn). Khi đã chọn α, bạn mới quay lại diễn giải p-value.

3) Cách tính p: hiểu bản chất trước khi bấm phần mềm

Để hiểu cách tính p, bạn cần hình dung quy trình chung của kiểm định:

- Chọn kiểm định phù hợp (ví dụ kiểm định t test, ANOVA, chi-square…).

- Tính thống kê kiểm định (t, F, χ²…), dựa trên dữ liệu mẫu.

- Giả sử H0 đúng, xác định phân phối của thống kê kiểm định.

- Tính xác suất rơi vào vùng “cực đoan” bằng hoặc hơn giá trị quan sát được → đó là p-value.

Nói cách khác, cách tính p không phải là một công thức duy nhất áp dụng cho mọi trường hợp. Nó phụ thuộc vào loại kiểm định bạn dùng, loại dữ liệu (định lượng/định tính), số nhóm, và giả định của mô hình.

Ví dụ với kiểm định t test (một trong các kiểm định phổ biến nhất):

- Bạn tính được giá trị thống kê t từ dữ liệu.

- Dựa vào bậc tự do (df) và dạng kiểm định (1 đuôi hay 2 đuôi), bạn suy ra p-value từ phân phối t.

Trong nghiên cứu thực tế, cách tính p thường được thực hiện bởi phần mềm (SPSS, R, Stata, Excel…), nhưng người làm phân tích vẫn cần hiểu ý nghĩa để tránh đọc sai kết quả.

4) Cách tính p trong SPSS (thao tác dễ áp dụng)

Dưới đây là hướng dẫn cách tính p trên SPSS theo hướng “làm được ngay”. Bạn có thể áp dụng cho kiểm định t test và nhiều kiểm định khác.

4.1. Chuẩn bị dữ liệu

- Mở SPSS và nạp file dữ liệu.

- Kiểm tra kiểu biến: định lượng (Scale) hay phân loại (Nominal/Ordinal).

- Rà soát giá trị thiếu (missing) và ngoại lệ nếu cần.

4.2. Cách tính p với kiểm định t test một mẫu (One-Sample T Test)

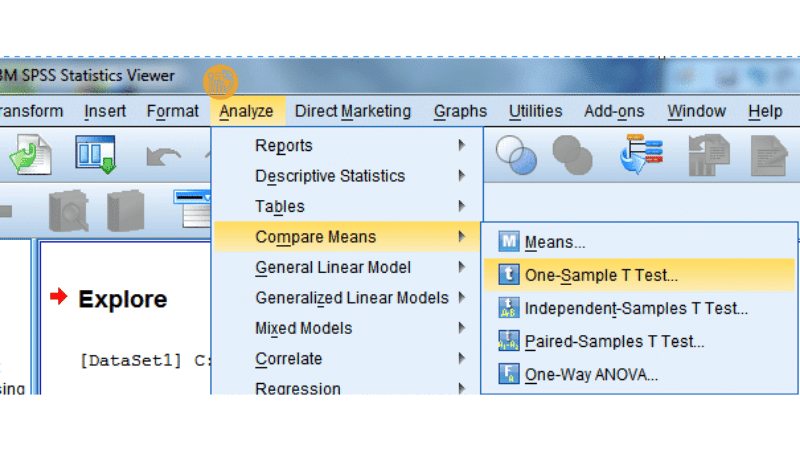

- Vào Analyze → Compare Means → One-Sample T Test.

- Đưa biến định lượng vào ô Test Variable(s).

- Nhập giá trị kiểm định (Test Value) theo H0 (ví dụ trung bình kỳ vọng).

- Chọn Options để đặt mức độ tin cậy (thường 95%).

- Nhấn OK để chạy.

Kết quả sẽ có cột Sig. (2-tailed). Đây chính là p-value cho kiểm định hai đuôi. Như vậy, cách tính p trong trường hợp này về mặt thao tác là đọc Sig. (2-tailed) trong bảng kết quả.

4.3. Cách tính p với kiểm định t test hai mẫu độc lập (Independent-Samples T Test)

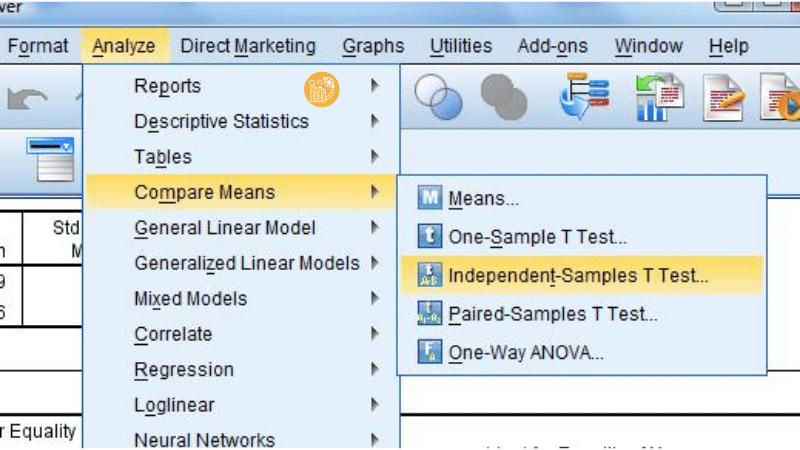

- Vào Analyze → Compare Means → Independent-Samples T Test.

- Đưa biến định lượng vào Test Variable(s).

- Đưa biến nhóm (2 nhóm) vào Grouping Variable và Define Groups.

- Nhấn OK.

SPSS sẽ cho 2 dòng kết quả dựa trên kiểm định Levene (đánh giá giả định phương sai bằng nhau). Bạn cần chọn dòng phù hợp rồi đọc Sig. (2-tailed) để lấy p-value. Đây là điểm hay bị sai khi người mới chỉ nhìn một con số mà không xét điều kiện đi kèm.

Tóm lại, cách tính p trong SPSS thường là: chạy đúng kiểm định → đọc đúng cột Sig tương ứng → diễn giải theo mức ý nghĩa thống kê đã chọn.

5) Cách đọc p-value: 0,01; 0,05 và >0,05 có ý nghĩa gì?

Khi phân tích kết quả thống kê, bạn nên diễn giải p-value theo ngưỡng α đã định trước. Dưới đây là cách diễn giải phổ biến:

5.1. p-value ≤ 0,01

Đây là bằng chứng rất mạnh chống lại H0 (với α = 0,01). Khi đó, bạn có thể bác bỏ H0 và nói rằng kết quả có ý nghĩa thống kê ở mức 1%.

5.2. p-value ≤ 0,05

Đây là mức thường dùng trong nhiều lĩnh vực. Nếu p-value nhỏ hơn hoặc bằng 0,05 (và bạn chọn α = 0,05), bạn bác bỏ H0 và kết luận có ý nghĩa thống kê.

5.3. p-value > 0,05

Bạn chưa đủ bằng chứng để bác bỏ H0. Lưu ý: điều này không đồng nghĩa “H0 đúng”, mà là dữ liệu chưa cho thấy bằng chứng đủ mạnh theo tiêu chuẩn bạn đặt ra.

Trong thực hành, phân tích kết quả thống kê nên đi kèm kích thước hiệu ứng (effect size), khoảng tin cậy và bối cảnh nghiên cứu. p-value chỉ là một mảnh ghép.

6) Ứng dụng của p-value trong nghiên cứu và thực tiễn

p-value xuất hiện trong rất nhiều bài toán phân tích dữ liệu:

- Kiểm định giả thuyết: quyết định bác bỏ hay không bác bỏ H0 dựa trên mức ý nghĩa thống kê.

- Kiểm định t test: so sánh trung bình (một mẫu, hai mẫu độc lập, hai mẫu ghép cặp).

- ANOVA: so sánh từ 3 nhóm trở lên.

- Chi-square: kiểm tra mối liên hệ giữa các biến phân loại.

- Hồi quy: đánh giá ý nghĩa thống kê của hệ số, hỗ trợ chọn biến (nhưng không nên lạm dụng).

- Nghiên cứu y tế/lâm sàng: so sánh hiệu quả can thiệp, đánh giá khác biệt nhóm.

Dù ở trường hợp nào, cách tính p luôn gắn với “loại kiểm định” và “giả định” của mô hình, chứ không phải chỉ là một thao tác bấm nút.

7) Những lỗi phổ biến khi dùng p-value (và cách tránh)

- Nhầm p-value với độ lớn tác động: p nhỏ không có nghĩa hiệu ứng mạnh; nó còn phụ thuộc cỡ mẫu.

- Chạy nhiều kiểm định rồi chỉ chọn cái p nhỏ: dễ gây sai lầm do kiểm định lặp (multiple testing).

- Không đọc đúng bảng kết quả: đặc biệt ở Independent T Test cần xét Levene trước.

- Không đặt α trước khi phân tích: dễ “đổi ngưỡng” để hợp ý, làm giảm độ tin cậy nghiên cứu.

Nếu bạn muốn bài viết/luận văn “đứng vững”, hãy trình bày rõ: bạn dùng kiểm định gì, giả thuyết ra sao, chọn mức ý nghĩa thống kê bao nhiêu, và diễn giải p-value theo đúng logic kiểm định giả thuyết.

8) Checklist nhanh: cách tính p và đọc kết quả trong báo cáo

- Xác định mục tiêu so sánh/kiểm tra mối liên hệ.

- Chọn đúng kiểm định (ưu tiên theo loại biến và thiết kế nghiên cứu).

- Chọn mức ý nghĩa thống kê (α) trước khi chạy.

- Chạy kiểm định trên phần mềm.

- Trích p-value (Sig) đúng dòng/đúng cột.

- Viết kết luận: bác bỏ hay không bác bỏ H0, kèm bối cảnh và chỉ số bổ sung nếu có.

Áp dụng đúng checklist này, bạn sẽ thấy cách tính p trở nên rõ ràng và việc phân tích kết quả thống kê cũng dễ “kể chuyện” hơn trong bài nghiên cứu.

9) Hỗ trợ xử lý số liệu khi bạn cần đúng kết quả và đúng deadline

Nếu bạn đang bí ở bước chọn kiểm định, chạy kiểm định t test, hoặc phân tích kết quả thống kê để viết báo cáo, bạn có thể tham khảo dịch vụ tại xulysolieu.info (Xử lý số liệu). Đội ngũ hỗ trợ theo hướng giải thích dễ hiểu, bám sát kiểm định giả thuyết và chuẩn trình bày học thuật, giúp bạn nắm chắc cách tính p thay vì chỉ nhận một bảng kết quả.

Liên hệ: 0878968468 hoặc truy cập xulysolieu.info để được tư vấn.

Công thức tính độ tin cậy trong nghiên cứu: Hướng dẫn nhanh và chính xác

Trong nghiên cứu định lượng, đặc biệt là các đề tài sử dụng dữ liệu khảo sát, một câu hỏi luôn được đặt ra trước khi đi sâu vào phân tích là: thang đo có đáng tin cậy hay không? Đây chính là lý do vì sao công thức tính độ tin cậy trở thành kiến thức nền tảng mà bất kỳ người làm nghiên cứu nào cũng cần nắm vững. Độ tin cậy giúp đánh giá mức độ nhất quán của dữ liệu, từ đó đảm bảo rằng các kết quả phân tích nhân tố hay mô hình hồi quy phía sau có ý nghĩa khoa học.

Bài viết này trình bày khái niệm độ tin cậy, vai trò của nó trong nghiên cứu, các yếu tố ảnh hưởng và đặc biệt là cách hiểu đúng công thức tính độ tin cậy theo hướng thực hành, dễ áp dụng cho các nghiên cứu sử dụng dữ liệu khảo sát.

Độ tin cậy trong nghiên cứu là gì?

Độ tin cậy trong nghiên cứu được hiểu là mức độ ổn định và nhất quán của một thang đo khi đo lường cùng một khái niệm. Nếu một thang đo có độ tin cậy cao, các biến quan sát trong thang đo đó sẽ cho kết quả tương đối giống nhau khi đo lặp lại trong cùng điều kiện.

Trong nghiên cứu định lượng, đặc biệt là các nghiên cứu về hành vi, quản trị, marketing hay khoa học xã hội, độ tin cậy thang đo phản ánh chất lượng dữ liệu khảo sát. Một thang đo không đạt độ tin cậy sẽ làm sai lệch toàn bộ kết quả phân tích phía sau, dù phương pháp phân tích có hiện đại đến đâu.

Vì sao cần quan tâm đến công thức tính độ tin cậy?

Trước khi đi vào phân tích nhân tố hay hồi quy, nhà nghiên cứu cần kiểm tra độ tin cậy của thang đo. Đây là bước sàng lọc dữ liệu nhằm đảm bảo rằng các biến quan sát thực sự đo lường cùng một khái niệm.

Công thức tính độ tin cậy giúp:

- Đánh giá mức độ nhất quán nội tại của thang đo.

- Loại bỏ các biến quan sát không phù hợp.

- Nâng cao chất lượng dữ liệu khảo sát trước khi phân tích sâu.

- Giảm rủi ro kết luận sai trong nghiên cứu.

Do đó, việc hiểu và áp dụng đúng công thức tính độ tin cậy là yêu cầu bắt buộc trong reliability analysis.

Cronbach Alpha và công thức tính độ tin cậy

Khi nhắc đến công thức tính độ tin cậy, chỉ số được sử dụng phổ biến nhất chính là Cronbach Alpha. Đây là thước đo phản ánh mức độ tương quan nội tại giữa các biến quan sát trong cùng một thang đo.

Về bản chất, Cronbach Alpha cho biết các biến quan sát có “đi cùng nhau” hay không khi cùng đo lường một khái niệm. Giá trị Cronbach Alpha càng cao thì độ tin cậy thang đo càng tốt.

Công thức tính độ tin cậy theo Cronbach Alpha có dạng tổng quát:

α = (k / (k − 1)) × [1 − (∑σi2 / σt2)]

Trong đó:

- k là số biến quan sát trong thang đo.

- σi2 là phương sai của từng biến quan sát.

- σt2 là phương sai tổng của thang đo.

Từ công thức tính độ tin cậy này, có thể thấy Cronbach Alpha chịu ảnh hưởng bởi cả số lượng biến quan sát và mức độ tương quan giữa chúng.

Ngưỡng đánh giá độ tin cậy thang đo

Trong thực hành nghiên cứu, người ta thường sử dụng các ngưỡng tham khảo để đánh giá độ tin cậy thang đo dựa trên Cronbach Alpha:

- α ≥ 0.8: thang đo rất tốt.

- 0.7 ≤ α < 0.8: thang đo đạt yêu cầu.

- 0.6 ≤ α < 0.7: có thể chấp nhận trong nghiên cứu khám phá.

- α < 0.6: thang đo không đáng tin cậy.

Tuy nhiên, các ngưỡng này không mang tính tuyệt đối. Việc đánh giá độ tin cậy còn phụ thuộc vào lĩnh vực nghiên cứu, mục tiêu nghiên cứu và đặc điểm dữ liệu khảo sát.

Độ tin cậy thang đo và mối quan hệ với phân tích nhân tố

Trong quy trình phân tích dữ liệu, độ tin cậy thang đo thường được kiểm tra trước khi thực hiện phân tích nhân tố. Lý do là phân tích nhân tố giả định rằng các biến quan sát trong cùng một nhóm có mối liên hệ chặt chẽ với nhau.

Nếu thang đo không đạt độ tin cậy, kết quả phân tích nhân tố sẽ không ổn định và khó diễn giải. Vì vậy, công thức tính độ tin cậy và Cronbach Alpha đóng vai trò như một bước “lọc dữ liệu” trước khi đi vào các kỹ thuật phân tích nâng cao.

Các yếu tố ảnh hưởng đến độ tin cậy

Dựa trên công thức tính độ tin cậy, có thể thấy một số yếu tố chính ảnh hưởng đến giá trị Cronbach Alpha:

- Số lượng biến quan sát: thang đo có nhiều biến quan sát thường cho độ tin cậy cao hơn.

- Mức độ tương quan giữa các biến: các biến càng tương quan chặt chẽ thì độ tin cậy càng cao.

- Chất lượng câu hỏi khảo sát: câu hỏi mơ hồ hoặc gây hiểu nhầm sẽ làm giảm độ tin cậy.

- Đặc điểm mẫu khảo sát: dữ liệu không đồng nhất hoặc có nhiều nhiễu sẽ ảnh hưởng đến kết quả.

Do đó, khi sử dụng công thức tính độ tin cậy, nhà nghiên cứu không nên chỉ nhìn vào con số Cronbach Alpha, mà cần xem xét cả nội dung câu hỏi và bối cảnh nghiên cứu.

Ứng dụng công thức tính độ tin cậy trong dữ liệu khảo sát

Trong các nghiên cứu sử dụng bảng hỏi, quy trình phổ biến thường là:

- Thu thập dữ liệu khảo sát.

- Thực hiện reliability analysis bằng Cronbach Alpha.

- Loại bỏ các biến quan sát có hệ số tương quan biến-tổng thấp.

- Giữ lại thang đo đạt độ tin cậy để tiếp tục phân tích nhân tố và mô hình.

Nhờ áp dụng đúng công thức tính độ tin cậy, nhà nghiên cứu có thể nâng cao độ chính xác của kết quả và đảm bảo rằng các kết luận đưa ra dựa trên dữ liệu chất lượng.

Nếu bạn đang gặp khó khăn trong việc kiểm tra độ tin cậy thang đo, đọc kết quả Cronbach Alpha hoặc kết hợp độ tin cậy với phân tích nhân tố, bạn có thể tham khảo thêm các hướng dẫn chi tiết tại xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được hỗ trợ.

Phân biệt độ tin cậy và giá trị thang đo

Một điểm cần lưu ý là độ tin cậy không đồng nghĩa với giá trị thang đo. Một thang đo có thể rất ổn định (độ tin cậy cao) nhưng vẫn không đo đúng khái niệm cần nghiên cứu. Vì vậy, công thức tính độ tin cậy chỉ là một phần trong quá trình đánh giá chất lượng thang đo, bên cạnh các kiểm định về giá trị nội dung, giá trị hội tụ và giá trị phân biệt.

Kết luận

Công thức tính độ tin cậy, tiêu biểu là Cronbach Alpha, là công cụ quan trọng giúp đánh giá chất lượng thang đo trong nghiên cứu định lượng. Việc hiểu đúng bản chất độ tin cậy thang đo, các yếu tố ảnh hưởng và cách diễn giải kết quả reliability analysis sẽ giúp bạn kiểm soát tốt dữ liệu khảo sát trước khi bước vào các phân tích sâu hơn như phân tích nhân tố hay mô hình hồi quy.

Nắm vững công thức tính độ tin cậy không chỉ giúp nghiên cứu của bạn chặt chẽ hơn về mặt thống kê, mà còn nâng cao giá trị học thuật và tính thuyết phục của toàn bộ đề tài.

Skewness và Kurtosis: Đánh giá phân phối dữ liệu trong SPSS

Trong thống kê mô tả và phân tích dữ liệu, việc kiểm tra dữ liệu có tuân theo phân phối chuẩn hay không là một bước rất quan trọng trước khi thực hiện các kiểm định và mô hình suy luận. Hai chỉ số thường xuyên được sử dụng cho mục đích này là Skewness (độ lệch) và kurtosis (độ nhọn). Đặc biệt trên SPSS, hai chỉ số này được dùng phổ biến vì dễ tính toán và dễ diễn giải trong thực hành nghiên cứu.

Bài viết này tập trung giải thích bản chất của skewness và kurtosis, cách đọc các giá trị này trên SPSS, tiêu chuẩn đánh giá phân phối chuẩn, cũng như những lưu ý quan trọng khi sử dụng hai chỉ số này trong kiểm tra dữ liệu và phân tích phân phối.

Vai trò của Skewness và Kurtosis trong phân tích phân phối

Trong phân tích phân phối, skewness phản ánh mức độ bất đối xứng của dữ liệu, còn kurtosis phản ánh hình dạng phân phối thông qua độ nhọn và độ dày của đuôi. Hai chỉ số này bổ trợ cho nhau, giúp người nghiên cứu đánh giá nhanh xem dữ liệu có xấp xỉ phân phối chuẩn hay không.

Việc hiểu đúng kurtosis đặc biệt quan trọng, vì nhiều người chỉ nhìn vào giá trị trung bình và độ lệch chuẩn mà bỏ qua hình dạng phân phối. Trong khi đó, dữ liệu có trung bình hợp lý nhưng kurtosis quá cao hoặc quá thấp vẫn có thể vi phạm giả định phân phối chuẩn.

Skewness là gì?

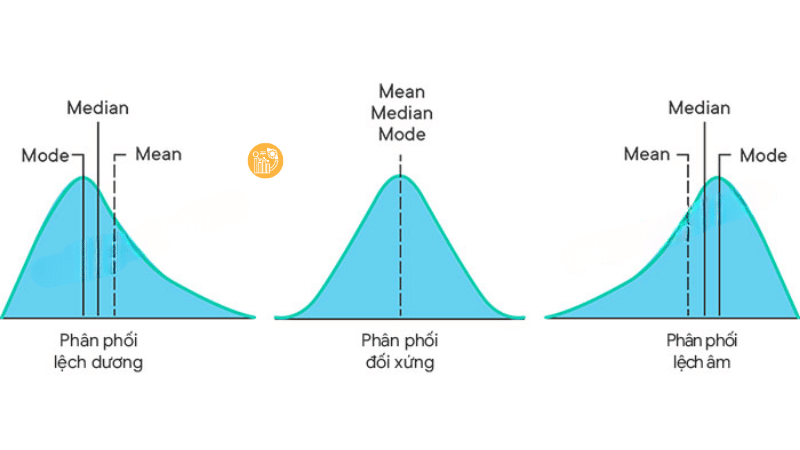

Skewness là chỉ số đo lường mức độ lệch của phân phối dữ liệu so với trạng thái đối xứng. Khi phân phối kéo dài nhiều về một phía, skewness sẽ khác 0. Trong thống kê mô tả, skewness giúp nhận diện nhanh dữ liệu có lệch phải hay lệch trái.

Nếu skewness lớn hơn 0, phân phối được gọi là lệch dương, tức là đuôi bên phải dài hơn. Nếu skewness nhỏ hơn 0, phân phối lệch âm, với đuôi bên trái dài hơn. Trường hợp skewness bằng 0 thể hiện phân phối đối xứng, đây là đặc điểm quan trọng của phân phối chuẩn.

Skewness thường được sử dụng song song với kurtosis để kiểm tra dữ liệu trước khi chạy các phân tích định lượng nâng cao.

Kurtosis là gì?

Kurtosis là chỉ số đo lường độ nhọn của phân phối dữ liệu so với phân phối chuẩn. Nói cách khác, kurtosis phản ánh dữ liệu tập trung nhiều ở trung tâm hay trải rộng ra hai phía đuôi. Đây là một chỉ số cốt lõi trong phân tích phân phối.

Về mặt lý thuyết, phân phối chuẩn có kurtosis bằng 3. Tuy nhiên, trong hầu hết các phần mềm thống kê, bao gồm SPSS, kurtosis đã được điều chỉnh về dạng độ nhọn dư thừa (Excess kurtosis), bằng cách lấy kurtosis trừ đi 3. Vì vậy, khi đọc kết quả trên SPSS, bạn cần so sánh kurtosis với giá trị 0 thay vì 3.

Hiểu đúng cách quy đổi này giúp tránh nhầm lẫn khi kiểm tra dữ liệu và đánh giá phân phối chuẩn trong thực tế nghiên cứu.

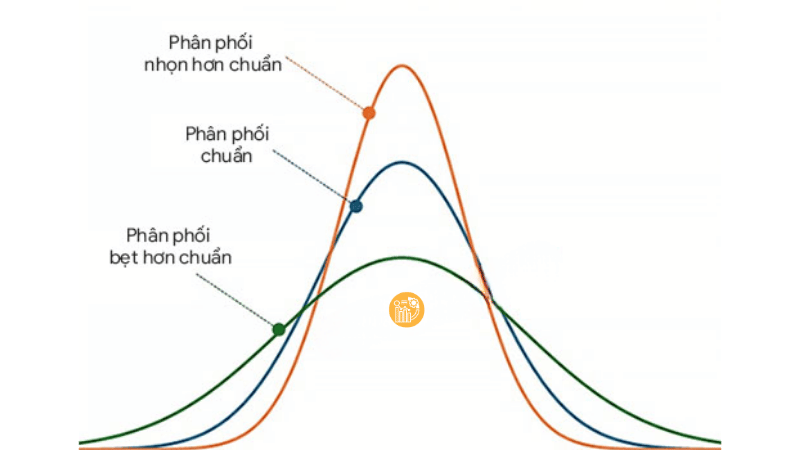

Các dạng phân phối dựa trên Kurtosis

Dựa vào giá trị kurtosis, phân phối dữ liệu có thể được phân thành ba dạng cơ bản. Khi kurtosis lớn hơn 0, phân phối được gọi là nhọn hơn chuẩn (leptokurtic), thể hiện dữ liệu tập trung nhiều ở trung tâm và có đuôi dày. Điều này cho thấy khả năng xuất hiện giá trị ngoại lai cao.

Khi kurtosis xấp xỉ 0, phân phối được xem là tương đương phân phối chuẩn (mesokurtic). Đây là trường hợp lý tưởng trong nhiều phân tích định lượng vì thỏa mãn giả định phân phối chuẩn.

Ngược lại, khi kurtosis nhỏ hơn 0, phân phối được gọi là bẹt hơn chuẩn (platykurtic). Lúc này, dữ liệu trải rộng hơn, đỉnh phân phối thấp và phẳng. Trường hợp này cũng có thể ảnh hưởng đến các kiểm định thống kê dựa trên giả định chuẩn.

Đánh giá phân phối chuẩn bằng Skewness và Kurtosis

Trong thực hành thống kê, người nghiên cứu thường dựa vào các ngưỡng tham khảo để đánh giá phân phối chuẩn. Theo nhiều tài liệu nghiên cứu, skewness và kurtosis nằm trong khoảng từ -1 đến 1 được xem là lý tưởng cho phân phối chuẩn.

Trong bối cảnh nghiên cứu ứng dụng, khoảng từ -2 đến 2 thường được chấp nhận, đặc biệt với cỡ mẫu lớn. Khi kurtosis vượt quá ngưỡng này, dữ liệu có khả năng không tuân theo phân phối chuẩn và cần được xem xét kỹ hơn.

Việc đánh giá dựa trên kurtosis không nên thực hiện một cách máy móc. Thay vào đó, cần đặt trong bối cảnh nghiên cứu, kích thước mẫu và mục tiêu phân tích dữ liệu.

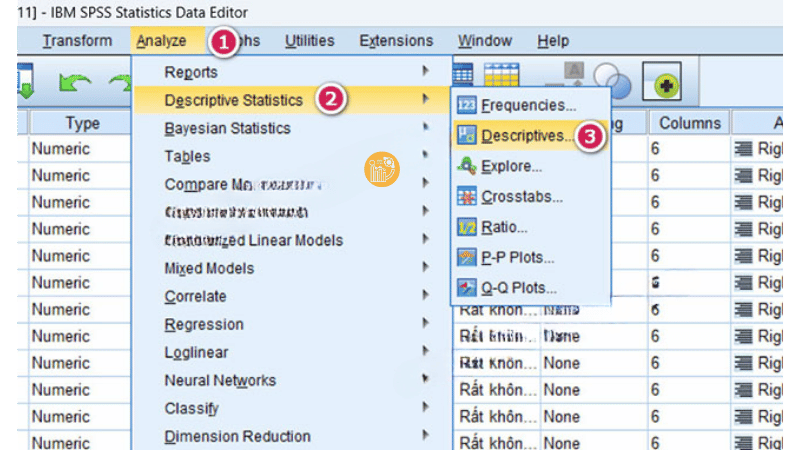

Cách tính Skewness và Kurtosis trong SPSS

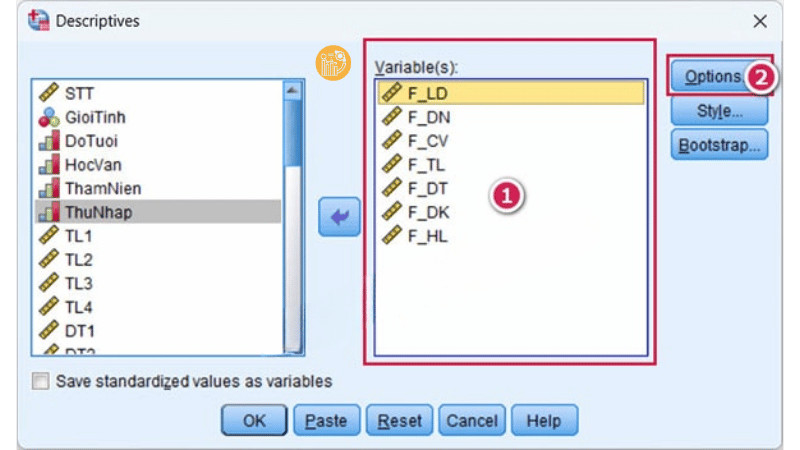

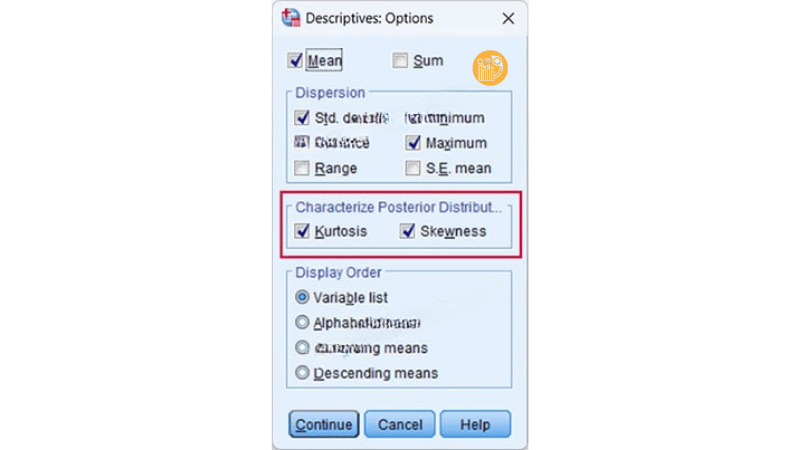

SPSS hỗ trợ tính skewness và kurtosis rất thuận tiện thông qua nhóm lệnh thống kê mô tả. Để kiểm tra dữ liệu, bạn vào Analyze, chọn Descriptive Statistics, sau đó chọn Descriptives.

Trong cửa sổ Descriptives, đưa các biến cần kiểm tra vào ô Variable(s). Tiếp theo, nhấn Options và tích chọn hai mục Skewness và Kurtosis. Sau khi xác nhận, SPSS sẽ xuất kết quả ra bảng Descriptive Statistics.

Trong bảng kết quả này, cột kurtosis chính là giá trị độ nhọn dư thừa. Việc hiểu rõ ý nghĩa của kurtosis trong bảng này là bước quan trọng để đánh giá phân phối dữ liệu.

Diễn giải kết quả Kurtosis trên SPSS

Khi đọc kết quả trên SPSS, nếu kurtosis của biến nằm trong khoảng chấp nhận, bạn có thể kết luận dữ liệu xấp xỉ phân phối chuẩn. Điều này cho phép tiếp tục sử dụng các kiểm định tham số như t-test, ANOVA hay hồi quy tuyến tính.

Nếu kurtosis quá cao hoặc quá thấp, bạn cần cân nhắc các phương án xử lý như biến đổi dữ liệu, sử dụng kiểm định phi tham số hoặc kết hợp thêm các công cụ đánh giá khác.

Trong mọi trường hợp, kurtosis chỉ là một chỉ báo. Việc diễn giải cần đi kèm với hiểu biết về từng biến và bối cảnh nghiên cứu cụ thể.

Kết hợp Kurtosis với các phương pháp kiểm tra khác

Trong phân tích phân phối, không nên chỉ dựa vào một mình kurtosis. Thay vào đó, bạn nên kết hợp nhiều phương pháp như biểu đồ Histogram, P-P Plot, Q-Q Plot, cùng với các kiểm định như Shapiro-Wilk hoặc Kolmogorov-Smirnov.

Việc kết hợp này giúp đánh giá phân phối dữ liệu một cách toàn diện hơn, hạn chế rủi ro kết luận sai khi dữ liệu có đặc điểm phức tạp.

Ý nghĩa thực tiễn của Kurtosis trong phân tích dữ liệu

Trong nghiên cứu định lượng, kurtosis giúp người phân tích hiểu rõ cấu trúc phân phối dữ liệu, đặc biệt là mức độ tập trung và rủi ro xuất hiện giá trị ngoại lai. Đây là thông tin rất quan trọng khi xây dựng mô hình thống kê hoặc mô hình hồi quy.

Ngoài ra, kurtosis còn hỗ trợ kiểm tra giả định của nhiều phương pháp phân tích, từ đó nâng cao độ tin cậy của kết quả nghiên cứu.

Kết luận

Skewness và kurtosis là hai chỉ số nền tảng trong thống kê mô tả và phân tích phân phối. Trong đó, kurtosis đóng vai trò quan trọng trong việc đánh giá độ nhọn của phân phối dữ liệu và mức độ phù hợp với phân phối chuẩn. Khi được sử dụng đúng cách và kết hợp với các phương pháp khác, hai chỉ số này giúp quá trình kiểm tra dữ liệu trở nên chính xác và khoa học hơn.

Nếu bạn đang gặp khó khăn trong việc kiểm tra phân phối dữ liệu, đọc kết quả skewness và kurtosis trên SPSS hoặc cần hỗ trợ phân tích dữ liệu nghiên cứu, bạn có thể liên hệ với xulysolieu.info – Xử lý số liệu hoặc truy cập xulysolieu.info. Hotline: 0878968468.

Cơ sở lý luận là gì? Ví dụ minh họa trong nghiên cứu sự hài lòng khách hàng

Trong nghiên cứu khoa học, đặc biệt là nghiên cứu định lượng và phân tích dữ liệu, cơ sở lý luận đóng vai trò như nền móng học thuật của toàn bộ đề tài. Rất nhiều sinh viên và người mới nghiên cứu thường lúng túng khi viết phần này, không biết nên trình bày thế nào cho đúng và đủ. Vì vậy, việc hiểu rõ bản chất và xem một ví dụ về cơ sở lý thuyết cụ thể sẽ giúp bạn xây dựng nghiên cứu chặt chẽ và logic hơn.

Bài viết này tập trung giải thích cơ sở lý luận là gì, vai trò của khung lý thuyết trong nghiên cứu khoa học, đồng thời đưa ra ví dụ về cơ sở lý thuyết minh họa trong một nghiên cứu về sự hài lòng của khách hàng. Nội dung được trình bày theo hướng dễ hiểu, sát thực tế và phù hợp với tư duy phân tích dữ liệu.

Cơ sở lý luận là gì?

Cơ sở lý luận, còn được gọi là khung lý thuyết, là hệ thống các khái niệm, nguyên lý, mô hình và giả thuyết khoa học được sử dụng làm nền tảng cho một nghiên cứu. Khi trả lời câu hỏi cơ sở lý luận là gì, có thể hiểu đơn giản rằng đây là phần giúp người đọc biết nghiên cứu đang dựa trên những lý thuyết nào, các khái niệm chính được hiểu ra sao và vì sao đề tài đó có ý nghĩa khoa học.

Trong nghiên cứu định lượng, cơ sở lý luận không chỉ mang tính mô tả mà còn định hướng cho việc xây dựng mô hình nghiên cứu, lựa chọn biến số và phương pháp phân tích. Do đó, phần này thường được xây dựng dựa trên tổng quan tài liệu, bao gồm các lý thuyết nền tảng và kết quả của các nghiên cứu trước.

Việc trình bày rõ ràng cơ sở lý luận giúp nghiên cứu tránh cảm tính, đảm bảo rằng mọi kết luận đều có căn cứ khoa học. Đây cũng là lý do vì sao trong các luận văn, luận án hay bài báo khoa học, phần này luôn được đánh giá rất kỹ.

Vai trò của cơ sở lý luận trong nghiên cứu khoa học

Để hiểu sâu hơn, cần nhìn vào vai trò của cơ sở lý luận trong toàn bộ quá trình nghiên cứu. Thứ nhất, cơ sở lý luận giúp xác định rõ phạm vi nghiên cứu và các khái niệm trung tâm. Điều này tránh tình trạng mỗi người hiểu một cách khác nhau về cùng một thuật ngữ.

Thứ hai, cơ sở lý luận là căn cứ để xây dựng giả thuyết nghiên cứu. Trong nghiên cứu định lượng, các giả thuyết không thể xuất hiện ngẫu nhiên mà phải xuất phát từ lý thuyết và bằng chứng trước đó. Đây là mối liên hệ chặt chẽ giữa cơ sở lý luận, mô hình nghiên cứu và phân tích dữ liệu.

Thứ ba, cơ sở lý luận giúp người đọc đánh giá mức độ khoa học và tính kế thừa của nghiên cứu. Một nghiên cứu có cơ sở lý luận rõ ràng sẽ cho thấy tác giả hiểu sâu vấn đề và đặt đề tài trong bối cảnh chung của lĩnh vực nghiên cứu.

Các thành phần cơ bản của cơ sở lý luận

Thông thường, một cơ sở lý luận đầy đủ sẽ bao gồm ba nhóm nội dung chính. Thứ nhất là hệ thống khái niệm và định nghĩa. Đây là phần làm rõ các thuật ngữ được sử dụng trong nghiên cứu, chẳng hạn như sự hài lòng, chất lượng dịch vụ hay sự trung thành của khách hàng.

Thứ hai là các lý thuyết và mô hình liên quan. Đây chính là “xương sống” của khung lý thuyết, nơi tác giả lựa chọn những lý thuyết phù hợp để giải thích hiện tượng nghiên cứu. Phần này thường gắn liền với tổng quan tài liệu.

Thứ ba là các nghiên cứu trước đây. Việc tổng hợp kết quả của các nghiên cứu liên quan giúp xác định khoảng trống nghiên cứu và củng cố lập luận cho mô hình nghiên cứu đề xuất.

Ví dụ về cơ sở lý thuyết trong nghiên cứu sự hài lòng khách hàng

Để làm rõ hơn, dưới đây là một ví dụ về cơ sở lý thuyết trong nghiên cứu sự hài lòng của khách hàng dành cho nhân viên hoặc doanh nghiệp. Ví dụ về cơ sở lý thuyết này mang tính minh họa, giúp bạn hình dung cách trình bày trong thực tế.

Chủ đề nghiên cứu: Các yếu tố ảnh hưởng đến sự hài lòng của khách hàng trong dịch vụ trực tuyến.

Trong ví dụ về cơ sở lý thuyết này, trước hết cần làm rõ các khái niệm chính. Sự hài lòng của khách hàng được hiểu là mức độ mà trải nghiệm thực tế của khách hàng đáp ứng hoặc vượt qua kỳ vọng ban đầu. Nghiên cứu sự hài lòng thường xem đây là biến phụ thuộc trung tâm của mô hình nghiên cứu.

Tiếp theo, cơ sở lý luận sẽ trình bày các lý thuyết liên quan. Một lý thuyết phổ biến được sử dụng là lý thuyết kỳ vọng – xác nhận, cho rằng sự hài lòng hình thành từ việc so sánh giữa kỳ vọng trước khi sử dụng dịch vụ và cảm nhận sau khi trải nghiệm. Đây là nền tảng quan trọng trong nhiều nghiên cứu định lượng về hành vi khách hàng.

Bên cạnh đó, mô hình SERVQUAL thường được đưa vào khung lý thuyết để đo lường chất lượng dịch vụ thông qua các thành phần như độ tin cậy, sự đáp ứng, sự đảm bảo, sự đồng cảm và yếu tố hữu hình. Trong ví dụ về cơ sở lý thuyết này, SERVQUAL đóng vai trò giải thích các yếu tố tác động đến sự hài lòng.

Phần tiếp theo của ví dụ về cơ sở lý thuyết là tổng quan các nghiên cứu trước. Nhiều nghiên cứu đã chỉ ra mối quan hệ tích cực giữa chất lượng dịch vụ và sự hài lòng, cũng như giữa sự hài lòng và ý định quay lại của khách hàng. Việc tổng hợp này giúp củng cố lập luận cho mô hình nghiên cứu đề xuất.

Cuối cùng, từ cơ sở lý luận và tổng quan tài liệu, nghiên cứu đề xuất mô hình nghiên cứu với các giả thuyết cụ thể, chẳng hạn: chất lượng dịch vụ có ảnh hưởng tích cực đến sự hài lòng của khách hàng; sự hài lòng có ảnh hưởng tích cực đến sự trung thành. Đây là kết quả trực tiếp của việc xây dựng ví dụ về cơ sở lý thuyết một cách bài bản.

Mối liên hệ giữa cơ sở lý luận và nghiên cứu định lượng

Trong nghiên cứu định lượng, cơ sở lý luận và phân tích dữ liệu có mối quan hệ chặt chẽ. Cơ sở lý luận định hướng việc lựa chọn biến quan sát, thang đo và phương pháp phân tích. Ngược lại, kết quả phân tích dữ liệu sẽ được diễn giải dựa trên khung lý thuyết đã xây dựng.

Một ví dụ về cơ sở lý thuyết rõ ràng sẽ giúp quá trình kiểm định giả thuyết trở nên logic và dễ hiểu hơn. Người đọc có thể dễ dàng theo dõi vì sao tác giả lựa chọn mô hình nghiên cứu như vậy và vì sao kết quả phân tích lại có ý nghĩa.

Lưu ý khi viết cơ sở lý luận

Khi viết cơ sở lý luận, bạn cần tránh sao chép máy móc tài liệu mà không phân tích. Thay vào đó, hãy chọn lọc những lý thuyết phù hợp nhất với mục tiêu nghiên cứu. Một ví dụ về cơ sở lý thuyết tốt không nằm ở độ dài, mà ở tính logic và liên kết chặt chẽ với mô hình nghiên cứu.

Ngoài ra, cơ sở lý luận nên được trình bày theo trình tự rõ ràng, từ khái niệm đến lý thuyết, từ nghiên cứu trước đến mô hình đề xuất. Điều này giúp người đọc dễ theo dõi và đánh giá chất lượng nghiên cứu.

Kết luận

Cơ sở lý luận là nền tảng không thể thiếu trong nghiên cứu khoa học, đặc biệt là nghiên cứu định lượng và nghiên cứu sự hài lòng khách hàng. Thông qua ví dụ về cơ sở lý thuyết được trình bày ở trên, có thể thấy rằng một khung lý thuyết rõ ràng sẽ giúp nghiên cứu có định hướng, logic và giá trị học thuật cao hơn.

Nếu bạn đang gặp khó khăn trong việc xây dựng cơ sở lý luận, tổng quan tài liệu hoặc thiết kế mô hình nghiên cứu và phân tích dữ liệu, bạn có thể tham khảo thêm các tài liệu chuyên sâu hoặc liên hệ với xulysolieu.info – Xử lý số liệu, hoặc truy cập xulysolieu.info. Hotline: 0878968468.

Khoảng tin cậy & Mức ý nghĩa: Hiểu đúng trong thống kê suy luận

Trong thống kê suy luận, khi làm việc với dữ liệu mẫu, chúng ta hiếm khi biết chính xác giá trị thật của tham số tổng thể. Thay vào đó, nhà nghiên cứu phải dựa vào ước lượng và chấp nhận một mức độ sai số nhất định. Đây chính là bối cảnh mà khoảng tin cậy và mức ý nghĩa xuất hiện như hai khái niệm nền tảng, giúp diễn giải kết quả phân tích dữ liệu một cách khoa học và thuyết phục.

Bài viết này sẽ giải thích khoảng tin cậy là gì, mối liên hệ giữa khoảng tin cậy và mức ý nghĩa, cách diễn giải đúng trong thống kê suy luận, cũng như những sai lầm phổ biến cần tránh khi ứng dụng vào nghiên cứu và phân tích dữ liệu.

Khoảng tin cậy là gì?

Khoảng tin cậy là một khoảng giá trị được xây dựng từ dữ liệu mẫu, với mục tiêu bao hàm giá trị thật của tham số tổng thể (ví dụ: trung bình, tỷ lệ) với một mức độ tin cậy xác định trước. Mức độ tin cậy này thường được biểu diễn bằng phần trăm, chẳng hạn 90%, 95% hoặc 99%.

Hiểu đúng bản chất, khoảng tin cậy không phải là xác suất để tham số tổng thể nằm trong một khoảng cụ thể sau khi đã tính toán. Thay vào đó, nó phản ánh mức độ tin cậy của phương pháp ước lượng: nếu lặp lại việc lấy mẫu và xây dựng khoảng tin cậy rất nhiều lần, thì một tỷ lệ nhất định (ví dụ 95%) trong số các khoảng đó sẽ chứa giá trị thật của tham số.

Trong phân tích dữ liệu, khoảng tin cậy giúp nhà nghiên cứu không chỉ đưa ra một con số ước lượng điểm, mà còn thể hiện mức độ không chắc chắn do sai số mẫu gây ra.

Vai trò của khoảng tin cậy trong thống kê suy luận

Trong thống kê suy luận, mục tiêu không chỉ là mô tả dữ liệu mẫu, mà còn suy rộng kết quả ra tổng thể. Khoảng tin cậy đóng vai trò cầu nối giữa mẫu và tổng thể, giúp:

- Đánh giá độ chính xác của ước lượng tham số.

- Thể hiện mức độ ảnh hưởng của sai số mẫu đến kết quả nghiên cứu.

- Hỗ trợ so sánh giữa các nhóm hoặc các điều kiện nghiên cứu.

- Cung cấp cơ sở diễn giải thực tiễn thay vì chỉ dựa vào kiểm định giả thuyết.

Trong nhiều trường hợp, việc báo cáo khoảng tin cậy còn mang nhiều thông tin hơn so với chỉ báo cáo giá trị trung bình hoặc p-value, vì nó cho thấy cả độ lớn hiệu ứng và mức độ bất định.

Mức ý nghĩa là gì và liên hệ với khoảng tin cậy

Mức ý nghĩa (ký hiệu α) là xác suất chấp nhận sai lầm loại I trong kiểm định giả thuyết, tức là xác suất bác bỏ giả thuyết không khi nó thực sự đúng. Các mức ý nghĩa phổ biến là 0.10, 0.05 và 0.01.

Giữa khoảng tin cậy và mức ý nghĩa tồn tại mối quan hệ chặt chẽ:

- Khoảng tin cậy 95% tương ứng với mức ý nghĩa α = 0.05.

- Khoảng tin cậy 99% tương ứng với mức ý nghĩa α = 0.01.

Nói cách khác, khi bạn chọn mức ý nghĩa cho kiểm định giả thuyết, bạn đồng thời đang xác định mức độ tin cậy của khoảng tin cậy tương ứng. Đây là lý do vì sao trong thống kê suy luận, khoảng tin cậy và mức ý nghĩa thường được trình bày song song.

Cấu trúc chung của một khoảng tin cậy

Một khoảng tin cậy thường có dạng:

Ước lượng điểm ± sai số biên

Trong đó, sai số biên phụ thuộc vào:

- Độ phân tán của dữ liệu (độ lệch chuẩn hoặc phương sai).

- Kích thước mẫu (cỡ mẫu càng lớn, sai số mẫu càng nhỏ).

- Mức độ tin cậy được lựa chọn.

Điều này cho thấy, khoảng tin cậy không chỉ phản ánh giá trị trung tâm, mà còn phản ánh chất lượng dữ liệu và thiết kế nghiên cứu. Với cùng một ước lượng tham số, cỡ mẫu lớn hơn sẽ cho khoảng tin cậy hẹp hơn, tức là kết quả chính xác hơn.

Khoảng tin cậy và ước lượng tham số

Trong ước lượng tham số, có hai cách tiếp cận chính: ước lượng điểm và ước lượng khoảng. Ước lượng điểm chỉ cung cấp một giá trị duy nhất, trong khi khoảng tin cậy cung cấp một khoảng giá trị có ý nghĩa thống kê.

Ví dụ, nếu trung bình mẫu là 50, khoảng tin cậy 95% là [48; 52], thì điều này cho thấy tham số tổng thể nhiều khả năng nằm trong khoảng từ 48 đến 52, với mức độ tin cậy 95%. So với con số 50 đơn lẻ, thông tin này giàu ý nghĩa hơn rất nhiều trong phân tích dữ liệu.

Chính vì vậy, trong các báo cáo khoa học và nghiên cứu ứng dụng, việc trình bày khoảng tin cậy cùng với ước lượng tham số ngày càng được khuyến khích.

Sai số mẫu và ảnh hưởng đến khoảng tin cậy

Sai số mẫu là sự khác biệt tự nhiên giữa giá trị ước lượng từ mẫu và giá trị thật của tổng thể. Sai số mẫu không thể loại bỏ hoàn toàn, nhưng có thể kiểm soát thông qua thiết kế nghiên cứu và cỡ mẫu.

Khoảng tin cậy là công cụ trực tiếp phản ánh sai số mẫu. Khi sai số mẫu lớn, khoảng tin cậy sẽ rộng; khi sai số mẫu nhỏ, khoảng tin cậy sẽ hẹp. Do đó, nếu bạn thấy một khoảng tin cậy rất rộng, điều này thường báo hiệu dữ liệu chưa đủ mạnh để đưa ra kết luận chắc chắn.

Trong thực hành thống kê suy luận, việc đánh giá độ rộng của khoảng tin cậy quan trọng không kém việc xem xét nó có chứa giá trị giả thuyết hay không.

Diễn giải đúng khoảng tin cậy trong nghiên cứu

Một trong những khó khăn lớn của người mới học thống kê là diễn giải khoảng tin cậy. Dưới đây là một cách diễn giải đúng:

“Với mức độ tin cậy 95%, chúng tôi tin rằng giá trị trung bình của tổng thể nằm trong khoảng từ A đến B.”

Không nên diễn giải rằng: “Xác suất để tham số nằm trong khoảng này là 95%”, vì sau khi đã tính toán, tham số là một hằng số cố định, không phải biến ngẫu nhiên.

Trong phân tích dữ liệu, cách diễn giải đúng giúp tránh hiểu sai kết quả và nâng cao tính học thuật của báo cáo nghiên cứu.

Khoảng tin cậy trong mối quan hệ với kiểm định giả thuyết

Khoảng tin cậy và kiểm định giả thuyết là hai cách tiếp cận khác nhau nhưng bổ trợ cho nhau trong thống kê suy luận. Một mối quan hệ thực tế thường được sử dụng là:

- Nếu giá trị giả thuyết nằm ngoài khoảng tin cậy ở mức tin cậy (1 − α), thì giả thuyết không bị bác bỏ ở mức ý nghĩa α.

- Nếu giá trị giả thuyết nằm trong khoảng tin cậy, thì không đủ bằng chứng để bác bỏ giả thuyết không.

Nhờ mối quan hệ này, nhiều nhà nghiên cứu предпоч́ dùng khoảng tin cậy để đưa ra kết luận trực quan hơn thay vì chỉ dựa vào p-value.

Ứng dụng khoảng tin cậy trong phân tích dữ liệu thực tế

Trong các lĩnh vực như kinh tế, quản trị, y sinh hay khoa học xã hội, khoảng tin cậy được sử dụng để:

- Đánh giá mức độ chính xác của các chỉ số thống kê.

- So sánh hiệu quả giữa các phương án hoặc nhóm đối tượng.

- Hỗ trợ ra quyết định dựa trên dữ liệu có tính bất định.

Việc hiểu và sử dụng đúng khoảng tin cậy giúp kết quả phân tích dữ liệu trở nên đáng tin cậy hơn, tránh các kết luận cực đoan dựa trên một con số duy nhất.

Nếu bạn đang học hoặc áp dụng thống kê suy luận trong nghiên cứu, bạn có thể tham khảo thêm các bài hướng dẫn chi tiết tại xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được hỗ trợ trực tiếp.

Kết luận

Khoảng tin cậy là một khái niệm trung tâm trong thống kê suy luận, giúp diễn giải kết quả ước lượng tham số một cách toàn diện hơn so với ước lượng điểm đơn thuần. Khi được đặt trong mối quan hệ với mức ý nghĩa, khoảng tin cậy không chỉ cho biết giá trị khả dĩ của tham số mà còn phản ánh độ tin cậy và sai số mẫu của nghiên cứu.

Nắm vững cách hiểu và sử dụng khoảng tin cậy sẽ giúp bạn nâng cao chất lượng phân tích dữ liệu, diễn giải kết quả chặt chẽ hơn và đưa ra kết luận khoa học, thuyết phục trong nghiên cứu và thực tiễn.

Hệ số tương quan tuyến tính Pearson: Khái niệm và cách diễn giải

Trong phân tích dữ liệu định lượng, có một câu hỏi gần như ai cũng gặp khi bắt đầu làm thống kê: hệ số tương quan tuyến tính là gì và vì sao nó xuất hiện trong hầu hết các báo cáo nghiên cứu? Khi bạn muốn đo lường mối quan hệ giữa hai biến số (ví dụ: thu nhập và chi tiêu, thời gian học và điểm số, chất lượng dịch vụ và sự hài lòng), cách đo cơ bản nhất thường là tương quan Pearson. Tuy nhiên, nếu chỉ nhìn một con số rồi kết luận “có liên hệ” hoặc “không liên hệ” thì rất dễ sai, vì hệ số này có nhiều tính chất và hạn chế quan trọng.

Bài viết dưới đây giải thích hệ số tương quan tuyến tính là gì theo cách dễ hiểu, đi thẳng vào bản chất, kèm tính chất, giới hạn và các ví dụ kinh điển để bạn diễn giải đúng trong nghiên cứu và trong phân tích tuyến tính.

Hệ số tương quan tuyến tính là gì?

Hệ số tương quan tuyến tính là gì? Đây là một thước đo dùng để đánh giá mức độ phụ thuộc tuyến tính giữa hai biến ngẫu nhiên (hoặc hai biến số trong dữ liệu). Hệ số tương quan tuyến tính Pearson (thường ký hiệu là r hoặc ρ) được xây dựng từ hiệp phương sai và phương sai của hai biến.

Về trực giác, tương quan Pearson trả lời câu hỏi: “Khi X tăng thì Y có xu hướng tăng theo (cùng chiều), giảm theo (ngược chiều), hay không có xu hướng tuyến tính rõ ràng?”. Vì vậy, hệ số tương quan tuyến tính là gì không chỉ là một công thức, mà là một cách đo lường mối quan hệ theo góc nhìn tuyến tính.

Giá trị của hệ số tương quan tuyến tính Pearson nằm trong khoảng từ -1 đến 1:

- Gần 1: quan hệ tuyến tính dương mạnh (X tăng thì Y thường tăng).

- Gần -1: quan hệ tuyến tính âm mạnh (X tăng thì Y thường giảm).

- Gần 0: không có quan hệ tuyến tính rõ ràng (nhưng chưa chắc “không liên hệ”).

Đến đây, bạn đã có nền tảng để trả lời hệ số tương quan tuyến tính là gì ở mức khái niệm. Phần tiếp theo sẽ giúp bạn hiểu sâu hơn về tính chất và cách diễn giải.

Tính chất quan trọng của tương quan Pearson

Để diễn giải đúng, bạn cần nắm một vài tính chất cốt lõi. Tính chất đầu tiên: hệ số tương quan tuyến tính là gì về mặt ý nghĩa? Nó là thước đo sự phụ thuộc tuyến tính. Nếu hai biến có quan hệ tuyến tính “hoàn hảo”, nghĩa là Y bằng aX + b gần như mọi nơi (với a khác 0), thì tương quan Pearson sẽ có trị tuyệt đối bằng 1. Đây là dấu hiệu mạnh nhất của quan hệ tuyến tính.

Tính chất thứ hai: tương quan Pearson không đổi qua phép biến đổi tuyến tính với hệ số dương. Nói dễ hiểu, nếu bạn đổi đơn vị đo (ví dụ đổi từ “triệu” sang “nghìn”, hoặc chuẩn hóa dữ liệu), thì hệ số tương quan tuyến tính là gì vẫn giữ nguyên về bản chất. Điều này rất hữu ích trong phân tích dữ liệu định lượng vì nó giúp bạn so sánh mối quan hệ mà không bị ảnh hưởng bởi thang đo.

Tuy nhiên, nếu phép biến đổi tuyến tính có hệ số âm (ví dụ nhân -1), dấu của hệ số tương quan sẽ đổi chiều. Đây là điểm nhỏ nhưng rất hay gặp khi bạn đảo mã thang đo.

Hệ số tương quan tuyến tính đo được gì và không đo được gì?

Phần này là nơi nhiều người hiểu sai. Hệ số tương quan tuyến tính là gì? Nó đo mức độ liên hệ tuyến tính, không phải mọi dạng liên hệ. Có những trường hợp X và Y liên quan rất mạnh nhưng theo dạng phi tuyến, khi đó tương quan Pearson có thể gần 0 và khiến bạn tưởng “không có mối quan hệ”.

Dưới đây là các hạn chế quan trọng cần nhớ khi dùng tương quan Pearson trong thống kê mô tả và phân tích tuyến tính:

- Chỉ đo phụ thuộc tuyến tính: nếu quan hệ là đường cong, r có thể thấp.

- Không bảo toàn qua biến đổi phi tuyến: lấy bình phương, log, mũ… có thể làm r thay đổi mạnh.

- Chỉ cho biết “mức độ” chứ không mô tả rõ “cấu trúc” phụ thuộc (dạng quan hệ cụ thể).

- Không xác định hoàn toàn phân phối chung của hai biến: cùng r nhưng dữ liệu có thể khác rất xa.

- Với Y là hàm phi tuyến của X, tương quan Pearson thường nhỏ hơn 1 dù dự đoán có thể rất tốt.

Vì vậy, khi trả lời hệ số tương quan tuyến tính là gì trong thực hành, bạn nên kèm thêm câu: “Nó chỉ phản ánh phần tuyến tính của mối quan hệ”.

Cách diễn giải hệ số tương quan tuyến tính trong phân tích dữ liệu

Trong phân tích dữ liệu định lượng, bạn thường diễn giải theo hai lớp: chiều hướng (dương/âm) và mức độ (mạnh/yếu). Một cách diễn giải đơn giản:

- 0.00–0.19: rất yếu

- 0.20–0.39: yếu

- 0.40–0.59: trung bình

- 0.60–0.79: mạnh

- 0.80–1.00: rất mạnh

Các ngưỡng này chỉ mang tính tham khảo và phụ thuộc lĩnh vực. Trong khoa học xã hội, r khoảng 0.30 đôi khi đã có ý nghĩa thực tiễn, còn trong kỹ thuật có thể cần cao hơn. Quan trọng hơn, hệ số tương quan tuyến tính là gì cũng phải đi kèm kiểm định ý nghĩa thống kê (p-value) nếu bạn muốn kết luận trên tổng thể.

Một lưu ý: tương quan không đồng nghĩa nhân quả. Hai biến có thể tương quan cao vì cùng bị ảnh hưởng bởi biến thứ ba. Vì vậy, trong báo cáo, bạn nên dùng ngôn ngữ “liên hệ” hoặc “đồng biến/ nghịch biến” thay vì “gây ra”.

Ba ví dụ giúp hiểu đúng “r = 0”

Đây là phần quan trọng nhất để tránh ngộ nhận. Rất nhiều người thấy r = 0 rồi kết luận “hai biến độc lập”. Thực tế, r = 0 chỉ nói rằng không có liên hệ tuyến tính, còn liên hệ phi tuyến vẫn có thể tồn tại.

Ví dụ 1: Quan hệ phi tuyến đối xứng

Giả sử Y = X2 và X đối xứng quanh 0. Khi đó, giá trị dương và âm của X tạo ra Y giống nhau, dẫn đến tương quan Pearson có thể bằng 0. Nhưng rõ ràng nếu biết X, bạn dự đoán được Y rất tốt. Trường hợp này cho thấy hệ số tương quan tuyến tính là gì: nó “không thấy” mối quan hệ dạng đường cong đối xứng.

Ví dụ 2: Tương quan bằng 0 nhưng vẫn phụ thuộc

Có những phân phối hai chiều mà tương quan Pearson bằng 0, nhưng X và Y không độc lập. Điều này thường xảy ra khi cấu trúc phụ thuộc bị “triệt tiêu” theo kiểu đối xứng, khiến hiệp phương sai bằng 0. Đây là lý do bạn không nên dùng r = 0 để khẳng định độc lập, nhất là trong nghiên cứu định lượng có dữ liệu phức tạp.

Ví dụ 3: Không tương quan nhưng dự đoán “gần như hoàn hảo”

Một số cấu trúc dữ liệu có thể cho r = 0 nhưng vẫn dự đoán tốt nếu biết biến còn lại, vì quan hệ nằm ở dạng phi tuyến hoặc ràng buộc theo miền giá trị. Ví dụ này nhắc lại rằng hệ số tương quan tuyến tính là gì: nó không mô tả đầy đủ cấu trúc phụ thuộc, chỉ đo phần tuyến tính.

Khi nào nên dùng tương quan Pearson trong thống kê mô tả?

Trong thống kê mô tả, tương quan Pearson phù hợp khi:

- Bạn muốn đo lường mối quan hệ giữa hai biến định lượng.

- Bạn nghi ngờ quan hệ gần tuyến tính (hoặc muốn kiểm tra giả thuyết tuyến tính).

- Dữ liệu không bị ngoại lệ (outlier) quá mạnh làm méo r.

Nếu bạn nghi ngờ quan hệ phi tuyến, hãy xem thêm scatter plot, hoặc cân nhắc tương quan Spearman (xếp hạng) như một lựa chọn bổ sung trong phân tích dữ liệu định lượng.

Kết luận

Hệ số tương quan tuyến tính là gì? Đó là thước đo mức độ phụ thuộc tuyến tính giữa hai biến, thường được thực hiện bằng tương quan Pearson trong thống kê mô tả và phân tích tuyến tính. Tuy nhiên, r chỉ phản ánh mối quan hệ theo đường thẳng; r gần 0 không có nghĩa là hai biến độc lập, và r cao cũng không chứng minh quan hệ nhân quả. Muốn diễn giải đúng, bạn nên kết hợp r với biểu đồ phân tán và bối cảnh nghiên cứu.

Nếu bạn cần hỗ trợ tính tương quan pearson, kiểm tra giả định, trực quan hóa mối quan hệ hoặc phân tích dữ liệu định lượng cho nghiên cứu, hãy liên hệ với xulysolieu.info – Xử lý số liệu hoặc truy cập xulysolieu.info. Hotline: 0878968468.

Tính mới trong nghiên cứu khoa học: Cách xác định và đánh giá

Trong hầu hết các luận văn, luận án và bài báo khoa học, một câu hỏi gần như luôn được hội đồng đặt ra là: nghiên cứu này có gì mới? Đây không chỉ là yêu cầu hình thức, mà là tiêu chí cốt lõi để đánh giá giá trị học thuật của một đề tài. Vì vậy, việc hiểu đúng và xác định rõ tính mới trong nghiên cứu khoa học là điều bắt buộc đối với bất kỳ ai theo đuổi con đường nghiên cứu.

Bài viết này trình bày một cách hệ thống khái niệm, vai trò, các dạng thể hiện và cách đánh giá tính mới trong nghiên cứu khoa học theo hướng dễ hiểu, tập trung vào tư duy nghiên cứu và phân tích dữ liệu, giúp bạn tránh những ngộ nhận phổ biến khi xây dựng đề tài.

Tính mới trong nghiên cứu khoa học là gì?

tính mới trong nghiên cứu khoa học được hiểu là những điểm khác biệt, bổ sung hoặc phát triển so với các công trình nghiên cứu đã có trước đó. Điểm mới này phải mang giá trị học thuật rõ ràng, có cơ sở lý luận hoặc thực nghiệm, và đóng góp vào việc mở rộng tri thức của lĩnh vực nghiên cứu.

Tính mới không đồng nghĩa với việc “chưa ai từng nghiên cứu”, mà quan trọng hơn là nghiên cứu của bạn giải quyết vấn đề theo cách nào khác, trong bối cảnh nào khác, với phương pháp nghiên cứu nào khác, hoặc cho ra kết quả và cách diễn giải mới.

Trong thực tế, tính mới trong nghiên cứu khoa học thường gắn chặt với khái niệm khoảng trống nghiên cứu. Khoảng trống nghiên cứu là những điểm còn bỏ ngỏ, chưa được giải thích đầy đủ, hoặc chưa được kiểm chứng trong các nghiên cứu trước. Việc nhận diện đúng khoảng trống này chính là nền tảng để hình thành tính mới.

Vai trò của tính mới trong nghiên cứu khoa học

tính mới trong nghiên cứu khoa học giữ vai trò trung tâm trong việc đánh giá chất lượng và giá trị của một công trình nghiên cứu. Cụ thể:

- Là tiêu chí quan trọng để xét duyệt đề cương, luận văn, luận án và bài báo khoa học.

- Thể hiện năng lực tư duy độc lập, khả năng tổng hợp và sáng tạo nghiên cứu của người làm khoa học.

- Giúp phân biệt nghiên cứu khoa học với các báo cáo mô tả hay tổng hợp đơn thuần.

- Đảm bảo rằng đề tài nghiên cứu thực sự đóng góp học thuật, không lặp lại máy móc kết quả cũ.

Với các nghiên cứu định lượng, tính mới trong nghiên cứu khoa học còn thể hiện ở cách xây dựng mô hình, lựa chọn biến, phương pháp phân tích dữ liệu và cách diễn giải kết quả. Đây là lý do vì sao nhiều đề tài có cùng chủ đề nhưng vẫn được đánh giá cao nếu thể hiện được góc nhìn mới hoặc cách tiếp cận mới.

Những ngộ nhận thường gặp về tính mới

Trước khi bàn sâu về cách xác định tính mới trong nghiên cứu khoa học, cần làm rõ một số hiểu lầm phổ biến:

- Cho rằng tính mới chỉ tồn tại khi đề tài hoàn toàn chưa từng xuất hiện.

- Nhầm lẫn giữa tính mới và sự khác biệt hình thức (đổi tên biến, đổi mẫu nhưng không đổi bản chất).

- Cho rằng chỉ cần thay đổi phương pháp nghiên cứu là đủ tạo ra tính mới.

Thực tế, tính mới trong nghiên cứu khoa học phải gắn với giá trị nội dung. Một thay đổi nhỏ nhưng có ý nghĩa về mặt lý thuyết, mô hình hoặc kết quả vẫn có thể được xem là đóng góp học thuật.

Các dạng phổ biến của tính mới trong nghiên cứu khoa học

Trong thực hành nghiên cứu, tính mới trong nghiên cứu khoa học thường xuất hiện dưới nhiều dạng khác nhau. Dưới đây là các dạng phổ biến nhất.

Tính mới về vấn đề nghiên cứu

Đây là dạng dễ nhận biết nhất. Nghiên cứu tập trung vào một vấn đề chưa được xem xét trước đó, hoặc một khía cạnh cụ thể của vấn đề cũ nhưng trong bối cảnh hoàn toàn mới. Ví dụ, một hiện tượng đã được nghiên cứu ở quốc gia phát triển nhưng chưa được kiểm chứng trong bối cảnh nền kinh tế đang phát triển.

Tính mới về đối tượng và bối cảnh nghiên cứu

Nhiều đề tài sử dụng lại khung lý thuyết cũ nhưng áp dụng cho đối tượng nghiên cứu mới, không gian mới hoặc thời điểm mới. Nếu sự khác biệt bối cảnh làm thay đổi kết quả hoặc cách giải thích, thì đây vẫn được xem là tính mới trong nghiên cứu khoa học.

Tính mới về phương pháp nghiên cứu

Tính mới có thể đến từ việc sử dụng phương pháp nghiên cứu khác với các nghiên cứu trước, hoặc kết hợp nhiều phương pháp theo cách mới. Trong phân tích dữ liệu, điều này thể hiện qua việc áp dụng kỹ thuật phân tích tiên tiến hơn, mô hình thống kê phù hợp hơn hoặc cách xử lý dữ liệu chặt chẽ hơn.

Tính mới về mô hình và biến nghiên cứu

Việc đề xuất mô hình nghiên cứu mới, bổ sung biến trung gian, biến điều tiết hoặc mối quan hệ chưa từng được kiểm định trước đó là một dạng tính mới trong nghiên cứu khoa học rất phổ biến ở luận văn thạc sĩ và luận án tiến sĩ.

Tính mới về kết quả và diễn giải

Ngay cả khi mô hình và phương pháp không hoàn toàn mới, kết quả nghiên cứu có thể khác biệt so với các nghiên cứu trước. Việc giải thích sự khác biệt này một cách logic và có cơ sở cũng tạo nên đóng góp học thuật.

Cách xác định tính mới trong nghiên cứu khoa học

Để xác định được tính mới trong nghiên cứu khoa học, người nghiên cứu cần đi qua một quy trình tư duy rõ ràng thay vì tìm kiếm “ý tưởng độc lạ” một cách cảm tính.

1. Tổng quan tài liệu có hệ thống

Việc đọc và phân tích các nghiên cứu trước giúp bạn nhận diện khoảng trống nghiên cứu. Bạn cần trả lời: các nghiên cứu đã làm gì, còn hạn chế gì, và chưa giải quyết vấn đề nào.

2. So sánh đề tài với nghiên cứu trước

Hãy đặt đề tài nghiên cứu của bạn cạnh các công trình liên quan và chỉ ra rõ điểm khác biệt. Điểm khác biệt này chính là hạt nhân của tính mới trong nghiên cứu khoa học.

3. Liên hệ mục tiêu nghiên cứu và phương pháp nghiên cứu

Tính mới phải gắn chặt với mục tiêu nghiên cứu. Một mục tiêu mới đòi hỏi cách tiếp cận và phương pháp nghiên cứu phù hợp, từ đó tạo ra đóng góp học thuật.

4. Kiểm chứng bằng dữ liệu và lập luận

Tính mới không thể chỉ tuyên bố bằng lời. Nó cần được thể hiện thông qua dữ liệu, mô hình, kết quả phân tích và lập luận khoa học.

Đánh giá tính mới trong nghiên cứu khoa học

Hội đồng khoa học thường đánh giá tính mới trong nghiên cứu khoa học dựa trên các tiêu chí sau:

- Mức độ khác biệt so với nghiên cứu trước.

- Giá trị đóng góp học thuật cho lĩnh vực.

- Tính hợp lý của lập luận và bằng chứng.

- Khả năng ứng dụng hoặc gợi mở hướng nghiên cứu tiếp theo.

Do đó, khi trình bày tính mới, bạn cần diễn đạt rõ ràng, tránh dùng các cụm từ chung chung như “nghiên cứu này có ý nghĩa thực tiễn” mà không chỉ ra cụ thể điểm mới nằm ở đâu.

Cách trình bày tính mới trong luận văn và bài báo

tính mới trong nghiên cứu khoa học nên được trình bày rõ ở phần mở đầu, tổng quan tài liệu và phần kết luận. Một cách trình bày hiệu quả là:

- Chỉ ra khoảng trống nghiên cứu từ tổng quan tài liệu.

- Nêu rõ nghiên cứu của bạn giải quyết khoảng trống đó như thế nào.

- Tóm tắt ngắn gọn các đóng góp học thuật chính.

Nếu bạn gặp khó khăn trong việc xác định hoặc diễn đạt tính mới trong nghiên cứu khoa học, bạn có thể tham khảo các bài hướng dẫn chuyên sâu tại xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được tư vấn theo đề tài cụ thể.

Kết luận

tính mới trong nghiên cứu khoa học không phải là điều xa vời hay chỉ dành cho những phát minh lớn. Nó có thể xuất hiện từ việc nhìn lại vấn đề cũ bằng góc nhìn mới, áp dụng phương pháp nghiên cứu phù hợp hơn, hoặc khai thác dữ liệu theo cách chặt chẽ hơn. Điều quan trọng là người nghiên cứu phải hiểu rõ khoảng trống nghiên cứu, xác định rõ đóng góp học thuật và trình bày tính mới một cách logic, có căn cứ.

Khi làm được điều đó, đề tài nghiên cứu của bạn sẽ không chỉ đáp ứng yêu cầu học thuật mà còn thể hiện rõ năng lực tư duy và sáng tạo nghiên cứu của chính bạn.

Correlation Coefficient là gì? Ý nghĩa và cách ứng dụng trong nghiên cứu

Khi làm phân tích dữ liệu thống kê, bạn sẽ thường gặp câu hỏi: hai biến có liên hệ với nhau không, và nếu có thì mạnh hay yếu? Đó là lúc correlation coefficient là gì trở thành kiến thức nền bắt buộc. Hệ số tương quan giúp đo mức độ “đi cùng nhau” của hai biến theo một hướng nhất định, từ đó hỗ trợ ra quyết định trong nghiên cứu, kinh doanh và đầu tư. Trong bài viết này, chúng ta sẽ đi thẳng vào khái niệm, cách hiểu đúng và ứng dụng thực tế của correlation coefficient là gì theo phong cách dễ hiểu, phục vụ học tập và phân tích dữ liệu.

Correlation coefficient là gì?

Correlation coefficient là gì? Đây là một chỉ số thống kê đo độ mạnh và hướng của mối quan hệ giữa hai biến khi chúng biến động cùng nhau. Thông thường, hệ số tương quan nằm trong khoảng từ -1 đến 1. Con số này không cho biết “nguyên nhân – kết quả”, mà chỉ phản ánh mức độ đồng biến hoặc nghịch biến giữa hai biến.

- Giá trị gần 1: mối quan hệ dương mạnh, một biến tăng thì biến còn lại có xu hướng tăng.

- Giá trị gần -1: mối quan hệ âm mạnh, một biến tăng thì biến còn lại có xu hướng giảm.

- Giá trị gần 0: không có tương quan tuyến tính rõ ràng (không có nghĩa là “không liên quan” trong mọi trường hợp).

Một lưu ý quan trọng khi học correlation coefficient là gì: hệ số tương quan vượt ngoài khoảng [-1, 1] thường là dấu hiệu tính toán sai hoặc dữ liệu bị lỗi. Vì vậy, nếu bạn thấy r > 1 hoặc r < -1, hãy kiểm tra lại cách nhập dữ liệu và công thức.

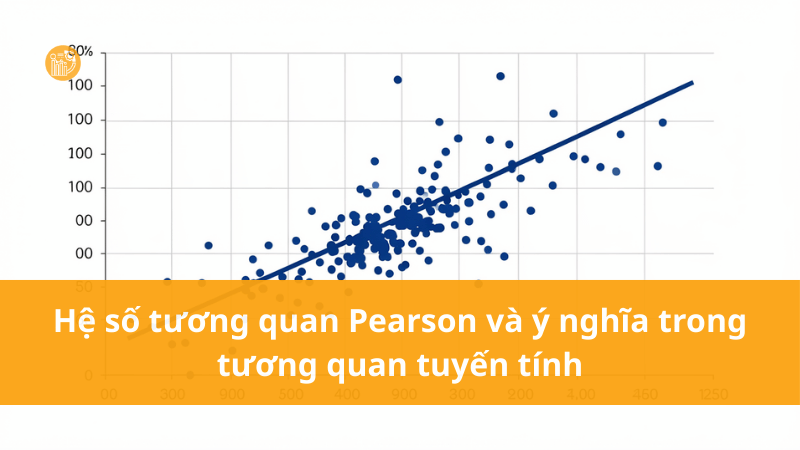

Hệ số tương quan Pearson và ý nghĩa trong tương quan tuyến tính

Trong nhiều tài liệu, khi nói correlation coefficient là gì, người ta thường nhắc đến hệ số tương quan Pearson (r). Đây là dạng phổ biến nhất vì nó đo tương quan tuyến tính giữa hai biến định lượng. “Tuyến tính” nghĩa là mối quan hệ có thể biểu diễn gần như một đường thẳng: X tăng thì Y tăng đều (hoặc giảm đều).

Cách hiểu nhanh:

- r = 1: tương quan dương hoàn hảo, điểm dữ liệu nằm trên một đường thẳng dốc lên.

- r = -1: tương quan âm hoàn hảo, điểm dữ liệu nằm trên một đường thẳng dốc xuống.

- r = 0: không có mối quan hệ tuyến tính rõ ràng giữa hai biến.

Trong phân tích mối quan hệ biến, nhiều người dùng “ngưỡng” để tham khảo độ mạnh: r khoảng 0.2 thường bị xem là yếu, 0.5 là trung bình, từ 0.8 trở lên là mạnh. Tuy nhiên, đây chỉ là quy ước tham khảo và còn phụ thuộc lĩnh vực nghiên cứu, cỡ mẫu và mục tiêu phân tích dữ liệu thống kê.

Correlation coefficient là gì?

Để hiểu sâu hơn correlation coefficient là gì, bạn nên biết nó được tính như thế nào. Hệ số tương quan Pearson dựa trên mức độ “đồng biến” giữa X và Y so với độ phân tán của từng biến. Công thức thường gặp:

r = Σ[(xi − x̅)(yi − ȳ)] / √(Σ(xi − x̅)2 × Σ(yi − ȳ)2)

Trong đó:

- xi, yi: các giá trị quan sát của hai biến X và Y

- x̅, ȳ: giá trị trung bình của X và Y

- r: hệ số tương quan biểu thị mức độ tương quan tuyến tính

Nếu tính thủ công, bạn phải trừ trung bình, nhân chéo độ lệch, cộng dồn, rồi chia cho căn bậc hai của tích tổng bình phương độ lệch. Vì thế, trong thực tế phân tích dữ liệu thống kê, bạn nên dùng công cụ để tránh sai số và tiết kiệm thời gian.

Tính correlation coefficient nhanh bằng Excel và các công cụ phân tích dữ liệu

Khi áp dụng correlation coefficient là gì vào thực hành, bạn không cần tính tay. Excel có hàm CORREL giúp tính hệ số tương quan nhanh cho dữ liệu lớn. Ngoài ra, SPSS, R, Python, Stata đều có lệnh tính tương quan và xuất bảng tương quan tự động.

Điều quan trọng là: dù dùng công cụ nào, bạn vẫn phải kiểm tra dữ liệu đầu vào (thiếu dữ liệu, ngoại lệ, nhầm đơn vị) vì hệ số tương quan rất nhạy với lỗi dữ liệu.

Correlation coefficient có đo được tương quan phi tuyến không?

Một hiểu lầm phổ biến khi học correlation coefficient là gì là: r = 0 thì hai biến “không liên quan”. Thực tế, r = 0 chỉ nói rằng không có tương quan tuyến tính rõ ràng. Hai biến vẫn có thể liên hệ theo dạng cong (tương quan phi tuyến) như hình chữ U, chữ S hoặc các dạng phi tuyến khác.

Vì vậy, khi nghi ngờ có tương quan phi tuyến, bạn nên:

- Vẽ scatter plot để quan sát hình dạng quan hệ.

- Thử biến đổi dữ liệu (log, bình phương) hoặc dùng mô hình phi tuyến.

- Cân nhắc hệ số tương quan khác phù hợp hơn tùy bối cảnh.

Điểm này rất quan trọng trong phân tích mối quan hệ biến, vì nếu chỉ dựa vào Pearson r, bạn có thể bỏ sót những mối liên hệ thực sự tồn tại nhưng không tuyến tính.

Ứng dụng của correlation coefficient trong nghiên cứu và thực tiễn

Để thấy rõ correlation coefficient là gì trong đời sống phân tích, hãy xem nó được dùng vào đâu. Hệ số tương quan xuất hiện trong nhiều ngành vì nó giúp tóm tắt mối liên hệ giữa biến bằng một con số dễ so sánh.

1) Ứng dụng trong nghiên cứu khoa học và phân tích dữ liệu thống kê

Trong nghiên cứu, hệ số tương quan thường được dùng để khám phá dữ liệu ban đầu, kiểm tra giả thuyết sơ bộ và hỗ trợ lựa chọn biến cho mô hình hồi quy. Ví dụ, trước khi chạy hồi quy, bạn thường xem bảng tương quan để hiểu biến nào liên hệ mạnh với biến mục tiêu.

2) Ứng dụng trong tài chính và đầu tư

Trong đầu tư, correlation coefficient là gì gắn chặt với ý tưởng đa dạng hóa danh mục. Khi bạn kết hợp các tài sản có hệ số tương quan thấp hoặc tương quan âm, tổng rủi ro danh mục có thể giảm. Nhà phân tích còn dùng hệ số tương quan để quan sát sự thay đổi mối quan hệ theo thời gian, ví dụ cổ phiếu ngành ngân hàng có thể có xu hướng đồng biến với lãi suất trong một giai đoạn nhất định.

Nếu bạn đang học cách phân tích danh mục hoặc muốn hệ thống kiến thức thống kê ứng dụng, bạn có thể tham khảo thêm tại xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được hướng dẫn theo tình huống dữ liệu thực tế.

3) Ứng dụng trong kinh doanh và vận hành

Doanh nghiệp dùng hệ số tương quan để kiểm tra mối liên hệ giữa các chỉ số như chi phí quảng cáo và doanh số, chất lượng dịch vụ và tỷ lệ quay lại, thời gian giao hàng và mức độ hài lòng. Đây là bước “chẩn đoán” nhanh trước khi đi sâu vào mô hình dự báo.

Cách diễn giải đúng để tránh sai lầm

Khi áp dụng correlation coefficient là gì, bạn cần tránh ba lỗi diễn giải hay gặp:

- Nhầm tương quan thành nhân quả: tương quan không chứng minh X gây ra Y.

- Bỏ qua tương quan phi tuyến: r gần 0 không đảm bảo “không liên hệ”.

- Bị đánh lừa bởi ngoại lệ: một vài điểm dữ liệu bất thường có thể làm hệ số tương quan thay đổi mạnh.

Trong phân tích dữ liệu thống kê, một cách làm chắc chắn là kết hợp: hệ số tương quan + biểu đồ phân tán + hiểu bối cảnh dữ liệu. Khi ba yếu tố này thống nhất, kết luận của bạn sẽ đáng tin hơn nhiều.

Kết luận

correlation coefficient là gì? Đó là thước đo thống kê cho biết mức độ và hướng liên hệ giữa hai biến, thường dùng nhất để đánh giá tương quan tuyến tính thông qua hệ số tương quan Pearson. Nó giúp bạn phân tích mối quan hệ biến nhanh, hỗ trợ khám phá dữ liệu, xây dựng mô hình và ra quyết định trong nghiên cứu cũng như đầu tư. Tuy nhiên, để dùng đúng, bạn cần nhớ: tương quan không phải nhân quả, r gần 0 vẫn có thể có tương quan phi tuyến, và dữ liệu ngoại lệ có thể làm sai lệch kết quả.

Nếu bạn muốn học cách đọc bảng tương quan, cách kiểm tra giả định, và cách kết hợp tương quan với hồi quy trong phân tích dữ liệu thống kê, hãy truy cập xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được hỗ trợ.

Cách nhập dữ liệu vào EView cho người mới

Nếu bạn học kinh tế lượng hoặc đang làm bài nghiên cứu định lượng, EViews là phần mềm rất hay gặp vì giao diện gọn, thao tác nhanh và phù hợp cho cả dữ liệu chéo, dữ liệu chuỗi thời gian lẫn dữ liệu bảng panel. Tuy nhiên, rất nhiều bạn bị “kẹt” ngay từ bước đầu: cách nhập dữ liệu vào eview. Chỉ cần chọn sai cấu trúc workfile hoặc sai định dạng dữ liệu EViews, bạn sẽ gặp lỗi lệch số quan sát, biến không khớp, hoặc không chạy được mô hình.

Bài viết này tập trung đúng trọng tâm: cách nhập dữ liệu vào eview theo hai hướng phổ biến (nhập trực tiếp và nhập từ Excel/Word), kèm các lưu ý xử lý dữ liệu chuỗi thời gian, dữ liệu bảng panel, và mẹo kiểm tra dữ liệu trước khi phân tích kinh tế lượng.

Hiểu đúng về Workfile trước khi nhập liệu

Trước khi nói đến cách nhập dữ liệu vào eview, bạn cần hiểu EViews luôn làm việc thông qua “Workfile”. Workfile giống như một “khung dữ liệu” nơi bạn khai báo cấu trúc (dạng dữ liệu), số quan sát (sample) và tạo biến (series). Nếu khai báo Workfile sai, dữ liệu nhập vào có thể bị cắt, lệch dòng hoặc không nhận đúng thời gian.

Trong EViews, bạn sẽ thường gặp ba nhóm dữ liệu:

- Dữ liệu chéo (cross-section): nhiều đối tượng tại một thời điểm, ví dụ 30 hộ gia đình trong 1 tháng.

- Dữ liệu chuỗi thời gian (time series): theo thời gian, ví dụ giá vàng theo ngày/tháng/năm.

- Dữ liệu bảng panel: kết hợp đối tượng và thời gian, ví dụ 50 doanh nghiệp trong 10 năm.

Vì vậy, cách nhập dữ liệu vào eview luôn bắt đầu bằng việc chọn đúng Workfile structure type.

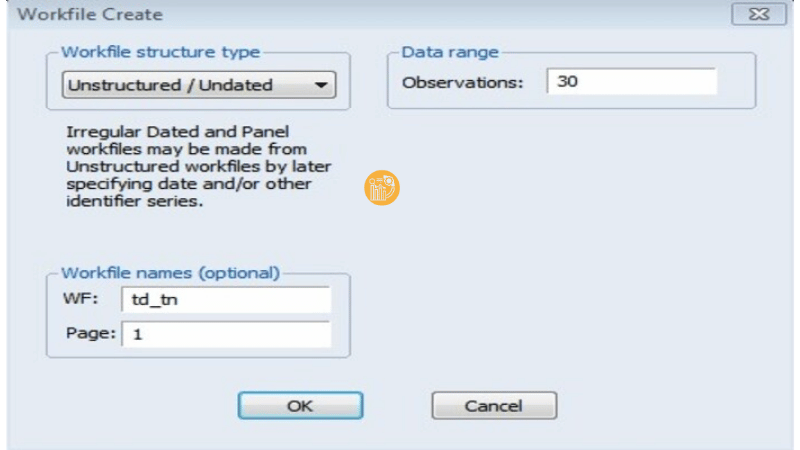

Cách nhập dữ liệu vào eview bằng nhập trực tiếp

Trường hợp bạn có dữ liệu ít và muốn nhập nhanh bằng tay, cách nhập dữ liệu vào eview theo hướng “nhập trực tiếp” rất tiện. Ví dụ khảo sát mối quan hệ giữa tiêu dùng và thu nhập của 30 hộ gia đình trong 1 tháng (dữ liệu chéo).

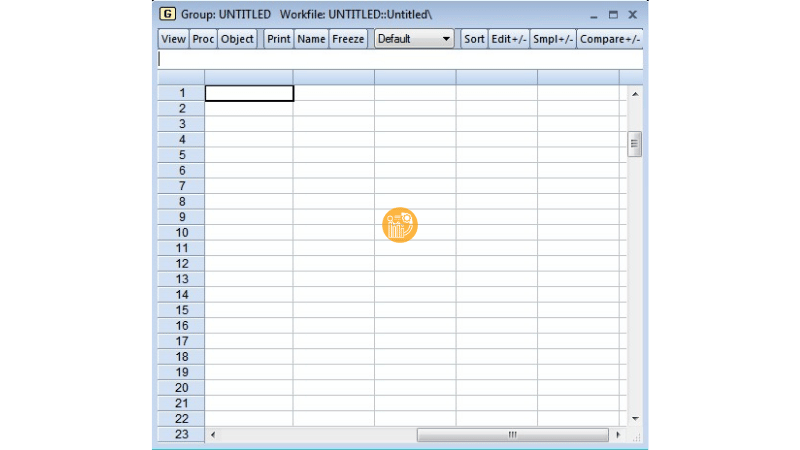

Bước 1: Tạo Workfile đúng loại dữ liệu

Vì là dữ liệu chéo, bạn chọn Workfile structure type là Unstructured/Undated. Ở phần Observations, nhập số quan sát tương ứng (ví dụ 30). Sau đó nhấn OK để tạo workfile.

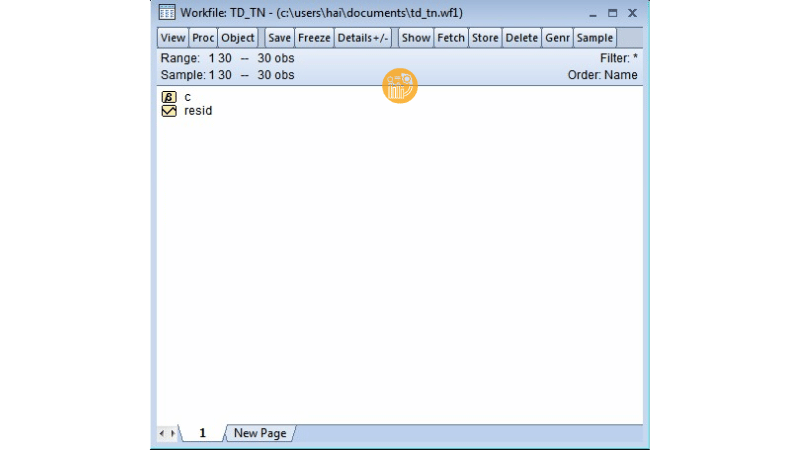

Khi workfile được tạo, bạn sẽ thấy thường có sẵn một vài đối tượng mặc định như:

- resid: vùng lưu phần dư (residuals) khi bạn chạy hồi quy.

- c: vùng lưu các hệ số/hằng số phục vụ ước lượng.

Đây là trạng thái bình thường, không phải lỗi. Quan trọng là bạn đã tạo được “khung” để thực hiện cách nhập dữ liệu vào eview.

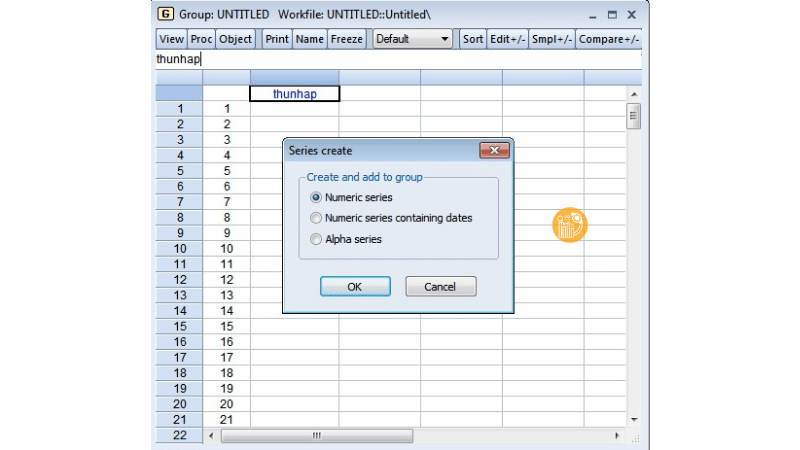

Bước 2: Tạo biến (series) để nhập dữ liệu

Trên thanh công cụ, chọn Quick > Empty Group (Edit Series). EViews sẽ mở một bảng dạng lưới. Bạn kéo thanh trượt để về dòng đầu và cột đầu, rồi nhập tên biến ở hàng tiêu đề, ví dụ THUNHAP và TIEUDUNG.

Ngay sau khi đặt tên biến, EViews có thể hỏi định dạng dữ liệu EViews cho biến. Thường bạn sẽ thấy các lựa chọn:

- Numeric series: dữ liệu số (hay dùng nhất trong phân tích kinh tế lượng).

- Numeric series containing dates: dữ liệu số có kèm ngày.

- Alpha series: dữ liệu dạng chuỗi/ký tự.

Với dữ liệu định lượng, bạn chọn Numeric series. Đây là điểm rất quan trọng trong cách nhập dữ liệu vào eview vì nếu bạn chọn nhầm Alpha series, EViews sẽ coi biến là chuỗi và không chạy được hồi quy.

Bước 3: Nhập dữ liệu và kiểm tra nhanh

Sau khi tạo biến, bạn nhập dữ liệu vào các ô tương ứng. Nếu bạn đã có dữ liệu trên Excel, bạn có thể copy và paste trực tiếp vào bảng này để tiết kiệm thời gian. Khi hoàn tất, các biến vừa tạo cũng sẽ xuất hiện trong cửa sổ Workfile.

Kết thúc phần này, bạn đã hoàn thành cách nhập dữ liệu vào eview theo kiểu nhập trực tiếp.

Cách nhập dữ liệu vào eview từ Excel hoặc Word có sẵn

Với bộ dữ liệu lớn (nhiều biến, nhiều quan sát), cách nhập dữ liệu vào eview từ Excel là lựa chọn tối ưu. Đây cũng là cách phổ biến khi bạn làm nghiên cứu khoa học, vì dữ liệu thường được tổng hợp trên Excel trước khi phân tích kinh tế lượng.

Chuẩn bị file Excel đúng chuẩn

Trước khi import, bạn nên chuẩn hóa file:

- Tên biến nằm ở dòng đầu tiên của mỗi cột.

- Dữ liệu bắt đầu từ dòng thứ 2 (ví dụ ô A2).

- Không để cột trống giữa các biến.

- Đóng file Excel trước khi import (EViews thường đọc ổn hơn khi file đang đóng).

Chuẩn bị đúng sẽ giúp cách nhập dữ liệu vào eview diễn ra mượt và giảm lỗi “lệch cột, lệch dòng”.

Bước 1: Tạo Workfile theo số quan sát

Nếu dữ liệu là dạng chéo, bạn vẫn chọn Unstructured/Undated và nhập Observations bằng số quan sát (ví dụ 100). Nếu là dữ liệu chuỗi thời gian, bạn cần khai báo thời gian bắt đầu và kết thúc theo tần suất (năm, quý, tháng, ngày). Với dữ liệu bảng panel, bạn cần khai báo cấu trúc panel phù hợp.

Nói cách khác, cách nhập dữ liệu vào eview từ Excel vẫn bắt đầu bằng “đúng Workfile”, đặc biệt quan trọng với xử lý dữ liệu chuỗi thời gian và dữ liệu bảng panel.

Bước 2: Import dữ liệu từ file

Trên thanh công cụ, chọn Procs > Import > Import from file, sau đó trỏ đến file Excel và nhấn Open.

EViews sẽ mở một trình hướng dẫn (wizard). Ở bước khai báo header, bạn chọn Header lines = 1 để EViews lấy dòng đầu tiên làm tên biến. Nếu chọn 2, EViews sẽ ghép 2 dòng đầu làm tên biến, thường khiến tên biến rối và khó dùng khi viết lệnh.

Tiếp theo, ở Data type, nếu dữ liệu là số thì chọn Number. Đây là phần “định dạng dữ liệu EViews” quan trọng để biến được nhận đúng dạng phục vụ phân tích kinh tế lượng.

Bước 3: Chọn phạm vi đưa dữ liệu vào Workfile

Ở phần Sample within destination workfile to place data, nếu bạn muốn lấy toàn bộ dữ liệu, nhập @all. Nếu bạn chỉ muốn nhập một đoạn quan sát (ví dụ từ 20 đến 30), bạn nhập 20 30.

Hoàn tất các bước, nhấn Finish. Lúc này, các biến sẽ xuất hiện trong Workfile và bạn đã hoàn thành cách nhập dữ liệu vào eview bằng import.

Lưu ý khi nhập dữ liệu chuỗi thời gian và dữ liệu bảng panel

Nhiều bạn làm sai cách nhập dữ liệu vào eview vì dùng cùng một cấu trúc cho mọi loại dữ liệu. Với xử lý dữ liệu chuỗi thời gian, bạn cần chọn đúng tần suất (yearly/quarterly/monthly/daily) và khai báo mốc thời gian bắt đầu – kết thúc. Nếu bạn khai báo sai, EViews vẫn nhập được nhưng “trục thời gian” sẽ sai, dẫn đến kết quả mô hình không đáng tin.

Với dữ liệu bảng panel, bạn cần xác định rõ số đối tượng và số thời kỳ. Khi khai báo đúng panel, EViews sẽ hiểu dữ liệu theo hai chiều và bạn có thể chạy các mô hình panel (Fixed Effects, Random Effects) thuận lợi. Vì vậy, cách nhập dữ liệu vào eview cho panel không chỉ là import, mà là “import đúng cấu trúc”.

Kiểm tra dữ liệu sau khi nhập để tránh lỗi khi chạy mô hình

Sau khi hoàn tất cách nhập dữ liệu vào eview, bạn nên làm 3 kiểm tra nhanh:

- Kiểm tra số quan sát: có đúng với dataset gốc không.

- Kiểm tra định dạng biến: biến số có bị nhận thành chuỗi không (Alpha series).

- Kiểm tra giá trị thiếu hoặc giá trị 0 bất thường trước khi ước lượng.

Chỉ cần vài phút kiểm tra, bạn sẽ tránh được rất nhiều lỗi khi chạy hồi quy hoặc khi xử lý dữ liệu chuỗi thời gian.

Kết luận

Cách nhập dữ liệu vào eview không khó, nhưng phải làm đúng từ bước chọn Workfile đến bước khai báo định dạng dữ liệu EViews. Bạn có thể nhập trực tiếp khi dữ liệu ít, hoặc import từ Excel khi dữ liệu lớn. Với dữ liệu chuỗi thời gian và dữ liệu bảng panel, hãy đặc biệt chú ý cấu trúc workfile để đảm bảo phân tích kinh tế lượng chạy đúng và kết quả đáng tin.

Nếu bạn cần hỗ trợ nhập dữ liệu EViews, làm sạch dữ liệu, xử lý dữ liệu chuỗi thời gian, dữ liệu bảng panel hoặc chạy mô hình kinh tế lượng, hãy liên hệ với xulysolieu.info – Xử lý số liệu hoặc truy cập xulysolieu.info. Hotline: 0878968468.

Phân tích thuật toán hồi quy Logistic nhị phân bằng SPSS từ A–Z

Nếu bạn đang làm nghiên cứu có biến kết quả chỉ có hai trạng thái (0/1), ví dụ “có/không”, “thành công/thất bại”, “trả nợ/không trả nợ”, thì thuật toán hồi quy logistic là một lựa chọn gần như bắt buộc. Bài viết này hướng dẫn cách hiểu, chạy và đọc kết quả thuật toán hồi quy logistic nhị phân (binary logistic) trong SPSS theo kiểu thực hành, đi thẳng vào những bảng quan trọng và cách diễn giải để phục vụ phân tích dữ liệu và dự báo.

Thuật toán hồi quy logistic là gì và dùng khi nào?

thuật toán hồi quy logistic là một phương pháp mô hình hóa mối quan hệ giữa biến phụ thuộc nhị phân và một hoặc nhiều biến độc lập. Thay vì dự đoán trực tiếp giá trị Y như hồi quy tuyến tính, thuật toán hồi quy logistic tập trung vào phân tích xác suất: ước lượng xác suất để sự kiện xảy ra (Y=1) khi các biến độc lập có một giá trị cụ thể.

Trong thực tế phân tích dữ liệu, bạn chọn thuật toán hồi quy logistic khi:

- Biến kết quả là biến phụ thuộc nhị phân (0/1).

- Bạn muốn dự báo xác suất (probability) thay vì dự đoán giá trị liên tục.

- Bạn cần giải thích tác động của biến độc lập lên khả năng xảy ra sự kiện.

Điểm quan trọng: khi Y chỉ có hai trạng thái, dùng hồi quy tuyến tính sẽ vi phạm giả định về phần dư phân phối chuẩn và dễ làm sai các kiểm định. Vì vậy, mô hình logistic và hồi quy logistic nhị phân được xây dựng để xử lý đúng bản chất phân phối nhị thức của dữ liệu.

Đặc điểm cốt lõi của hồi quy logistic nhị phân

Trong hồi quy logistic nhị phân, mô hình logistic tạo ra một giá trị đầu ra dạng xác suất trong khoảng 0 đến 1. Để làm được điều này, thuật toán hồi quy logistic sử dụng hàm sigmoid (đường cong chữ S) nhằm “ép” mọi tổ hợp tuyến tính của biến độc lập về miền xác suất.

Nói đơn giản, thay vì trả kết quả kiểu “-2.3” hay “3.7” như hồi quy tuyến tính, thuật toán hồi quy logistic sẽ cho bạn kết quả kiểu “0.82”, nghĩa là xác suất xảy ra sự kiện là 82%.

Phương trình mô hình logistic và ý nghĩa các thành phần

Với hồi quy logistic nhị phân, bạn thường gặp hai lớp biểu diễn: (1) phương trình logit và (2) phương trình xác suất. Trong phân tích dữ liệu bằng SPSS, nền tảng vẫn là ước lượng tham số các hệ số (B) để tối ưu khả năng dự báo.

Mô hình logistic thường được viết dưới dạng:

logit(P) = ln(P/(1-P)) = B0 + B1X1 + B2X2 + … + BkXk

Trong đó P là xác suất Y=1. Từ biểu thức logit, bạn suy ra công thức dự báo xác suất:

P = 1 / (1 + e-(B0 + B1X1 + … + BkXk))

Trong quá trình chạy logistic regression spss, SPSS sẽ thực hiện ước lượng tham số B0, B1…Bk (các hệ số hồi quy) và cung cấp các kiểm định phù hợp để bạn kết luận mô hình có ý nghĩa hay không.

Đánh giá độ phù hợp của thuật toán hồi quy logistic trên SPSS

Khi dùng thuật toán hồi quy logistic, bạn cần trả lời hai câu hỏi: mô hình có phù hợp không, và các biến có ý nghĩa không. SPSS cung cấp các bảng cốt lõi để xử lý hai câu hỏi này.

1) Kiểm định độ phù hợp mô hình bằng Chi-square

Khác hồi quy tuyến tính dùng kiểm định F, hồi quy logistic nhị phân dùng kiểm định Chi-square để so sánh mô hình “trống” (không có biến độc lập) với mô hình có biến độc lập. SPSS thể hiện kết quả này trong bảng Omnibus Tests of Model Coefficients.

Cách đọc nhanh:

- Nếu Sig. ở dòng Model < 0.05: mô hình logistic là phù hợp (mô hình có biến độc lập tốt hơn mô hình trống một cách có ý nghĩa thống kê).

- Nếu Sig. ≥ 0.05: cần xem lại biến đầu vào, dữ liệu, hoặc cách mã hóa.

Đây là bước bạn nên đọc đầu tiên khi đánh giá thuật toán hồi quy logistic trong logistic regression spss.

2) Chỉ số -2 Log Likelihood (-2LL)

-2LL là thước đo mức “không phù hợp” của mô hình: càng nhỏ càng tốt. SPSS cho bạn -2LL của mô hình trống và -2LL của mô hình đề xuất. Thông thường, nếu mô hình đề xuất có -2LL thấp hơn đáng kể, kết quả là tốt.

Tuy nhiên, khi Sig. Chi-square đã đạt ý nghĩa, việc so sánh -2LL chủ yếu mang tính minh họa bổ sung. Dù vậy, hiểu -2LL vẫn giúp bạn đọc báo cáo hồi quy logistic nhị phân mạch lạc hơn.

3) Pseudo R Square: Cox & Snell và Nagelkerke

Trong mô hình logistic, SPSS cung cấp hai chỉ số “R Square giả” gồm Cox & Snell R Square và Nagelkerke R Square. Hai chỉ số này càng lớn thì mô hình logistic càng phù hợp theo nghĩa tổng quát. Lưu ý: không diễn giải chúng giống hệt R Square trong hồi quy tuyến tính. Trong phân tích dữ liệu, hãy dùng chúng để tham khảo mức độ phù hợp, không phải để kết luận “giải thích bao nhiêu phần trăm biến thiên”.

Kiểm định ý nghĩa biến trong thuật toán hồi quy logistic

Sau khi mô hình đạt phù hợp, bạn cần kiểm tra biến độc lập nào thực sự có ảnh hưởng lên biến phụ thuộc nhị phân. Trong hồi quy logistic nhị phân, SPSS sử dụng kiểm định Wald thay vì kiểm định t.

Trong bảng Variables in the Equation, bạn chú ý:

- Sig. (Wald) < 0.05: biến có ý nghĩa thống kê.

- Dấu của B: cho biết tác động thuận (dương) hay nghịch (âm) lên log-odds, từ đó tác động lên xác suất.

- Exp(B): hệ số odds ratio, diễn giải theo “tỷ lệ tăng/giảm odds” khi X tăng 1 đơn vị.

Một lưu ý thực tế: trong hồi quy logistic nhị phân không có hệ số chuẩn hóa, vì vậy bạn không nên xếp hạng mức độ tác động theo cách của hồi quy tuyến tính.

Hướng dẫn chạy logistic regression spss từng bước

Dưới đây là quy trình chạy thuật toán hồi quy logistic trong SPSS theo cách phổ biến (Enter), phù hợp cho người mới bắt đầu:

Bước 1: Chuẩn bị dữ liệu và mã hóa biến

- Đảm bảo biến phụ thuộc nhị phân có mã 0 và 1 rõ ràng.

- Nếu biến độc lập là định tính nhiều nhóm, cần mã hóa biến giả (dummy) trước khi chạy mô hình logistic.

- Nếu biến là thang đo nhiều biến quan sát, tạo biến đại diện (trung bình/tổng) trước khi đưa vào phân tích.

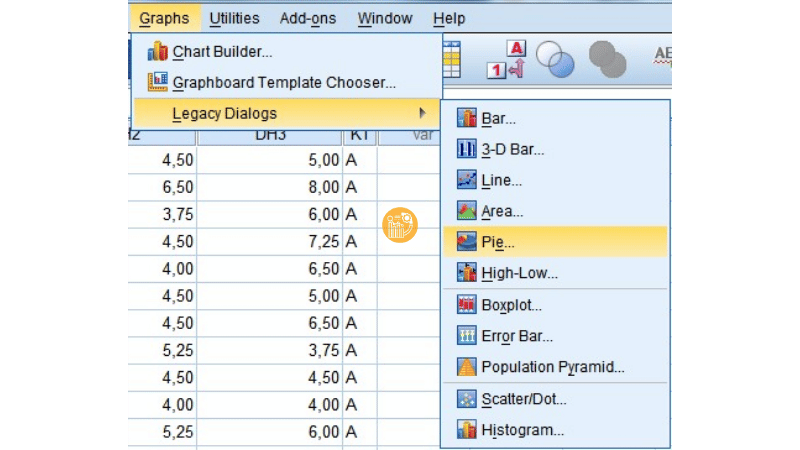

Bước 2: Mở hộp thoại hồi quy logistic nhị phân

Vào Analyze > Regression > Binary Logistic…

Bước 3: Khai báo biến

- Đưa Y vào Dependent.

- Đưa các X vào Covariates.

- Ở Method chọn Enter (đưa tất cả biến vào cùng lúc).

Bước 4: Tùy chọn hiển thị cần thiết

Trong Options, có thể chọn Iteration history để theo dõi lịch sử lặp. Nhấn OK để chạy.

Nếu bạn cần hướng dẫn thao tác SPSS theo dữ liệu luận văn cụ thể, bạn có thể tham khảo thêm tại xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468.

Cách đọc kết quả hồi quy logistic nhị phân trong SPSS

Khi SPSS trả output, bạn nên đọc theo thứ tự để không bỏ sót logic của thuật toán hồi quy logistic.

1) Case Processing Summary

Kiểm tra số quan sát hợp lệ, số thiếu dữ liệu, và số bị loại. Đây là bước đảm bảo dữ liệu đầu vào ổn trước khi diễn giải mô hình logistic.

2) Dependent Variable Encoding

Đảm bảo SPSS mã hóa đúng 0/1 cho biến phụ thuộc nhị phân. Sai mã hóa có thể làm bạn diễn giải ngược hoàn toàn ý nghĩa của kết quả.

3) Omnibus Tests of Model Coefficients

Đọc Sig. của dòng Model để kết luận mô hình có phù hợp không. Đây là “cổng vào” của toàn bộ diễn giải logistic regression spss.

4) Model Summary

Xem -2LL và Pseudo R Square (Cox & Snell, Nagelkerke) để đánh giá tổng quan độ phù hợp của mô hình logistic.

5) Classification Table

Bảng này cho biết khả năng phân loại đúng của mô hình: đúng bao nhiêu trường hợp Y=0 và Y=1, và tỷ lệ đúng chung. Với bài toán dự báo, đây là phần rất quan trọng khi bạn dùng thuật toán hồi quy logistic để ra quyết định.

6) Variables in the Equation

Đây là bảng “chốt kết luận” về biến: kiểm định Wald, hệ số B, và Exp(B). Từ đây, bạn viết kết luận biến nào có ý nghĩa, tác động thuận/nghịch, và diễn giải odds ratio theo ngữ cảnh nghiên cứu.

Ứng dụng dự báo: dùng mô hình logistic để tính xác suất

Một ưu điểm lớn của thuật toán hồi quy logistic là khả năng dự báo xác suất. Sau khi có phương trình, bạn thế giá trị X vào để tính P(Y=1). Nếu P lớn hơn một ngưỡng (thường 0.5), bạn phân loại là “xảy ra sự kiện”.

Ví dụ trong bối cảnh ngân hàng: biến phụ thuộc nhị phân là trả nợ (1) hoặc không trả nợ (0), các biến độc lập gồm tuổi và thu nhập. Khi có khách hàng mới, bạn đưa thông tin vào mô hình logistic để tính xác suất trả nợ. Nếu xác suất cao, ngân hàng có thể cân nhắc cho vay. Đây là cách logistic regression spss được dùng như một mô hình dự báo thực tế.

Kết luận

thuật toán hồi quy logistic là công cụ mạnh cho bài toán có biến phụ thuộc nhị phân, vừa hỗ trợ phân tích xác suất vừa phục vụ dự báo. Khi làm đúng quy trình trên SPSS, bạn chỉ cần tập trung vào các bảng cốt lõi: Omnibus (Chi-square), Model Summary (-2LL và Pseudo R Square), Classification Table (tỷ lệ dự đoán đúng) và Variables in the Equation (Wald, B, Exp(B)).

Nếu bạn muốn tối ưu cách chạy, cách mã hóa biến giả, cách trình bày kết quả hồi quy logistic nhị phân theo chuẩn luận văn và bám sát mục tiêu phân tích dữ liệu, hãy truy cập xulysolieu.info – Xử lý số liệu hoặc liên hệ 0878968468 để được hỗ trợ.